Minste kvadraters metode er bygget på betingelsen. Hvor brukes minste kvadraters metode?

Minste kvadraters metode er en av de vanligste og mest utviklet på grunn av sin enkelhet og effektivitet av metoder for å estimere parametrene for lineær. Samtidig bør det utvises en viss forsiktighet når du bruker den, siden modellene som er bygget ved hjelp av den, kanskje ikke oppfyller en rekke krav til kvaliteten på parameterne deres og som et resultat ikke "godt" gjenspeiler mønstrene for prosessutvikling.

La oss vurdere prosedyren for å estimere parametrene til en lineær økonometrisk modell ved å bruke minste kvadraters metode mer detaljert. En slik modell i generell form kan representeres ved ligning (1.2):

y t = a 0 + a 1 x 1 t +...+ a n x nt + ε t .

De første dataene ved estimering av parameterne a 0 , a 1 ,..., a n er vektoren av verdier til den avhengige variabelen y= (y 1 , y 2 , ... , y T)" og matrisen av verdier for uavhengige variabler

der den første kolonnen, bestående av enere, tilsvarer koeffisienten til modellen .

Metoden med minste kvadrater har fått navnet sitt basert på det grunnleggende prinsippet som parameterestimatene oppnådd på grunnlag av den skal tilfredsstille: summen av kvadrater av modellfeilen skal være minimal.

Eksempler på å løse problemer med minste kvadraters metode

Eksempel 2.1. Handelsbedriften har et nettverk bestående av 12 butikker, informasjon om aktivitetene til disse er presentert i tabell. 2.1.

Selskapets ledelse vil gjerne vite hvordan størrelsen på den årlige avhenger av salgsområdet til butikken.

Tabell 2.1

|

Butikknummer |

Årlig omsetning, millioner rubler |

Handelsareal, tusen m 2 |

Minste kvadraters løsning. La oss angi - den årlige omsetningen til den -th butikken, millioner rubler; - salgsareal til -th butikk, tusen m 2.

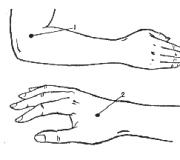

Fig.2.1. Scatterplot for eksempel 2.1

For å bestemme formen på den funksjonelle sammenhengen mellom variablene og konstruere et spredningsplott (fig. 2.1).

Basert på spredningsdiagrammet kan vi konkludere med at den årlige omsetningen er positivt avhengig av salgsarealet (dvs. y vil øke med veksten på ). Den mest hensiktsmessige formen for funksjonell tilkobling er − lineær.

Informasjon for videre beregninger er presentert i tabell. 2.2. Ved å bruke minste kvadraters metode estimerer vi parametrene til den lineære en-faktor økonometriske modellen

Tabell 2.2

Og dermed,

Derfor, med en økning i handelsområdet med 1 tusen m 2, alt annet like, øker den gjennomsnittlige årlige omsetningen med 67,8871 millioner rubler.

Eksempel 2.2. Ledelsen i bedriften la merke til at den årlige omsetningen ikke bare avhenger av salgsområdet til butikken (se eksempel 2.1), men også av gjennomsnittlig antall besøkende. Den relevante informasjonen er presentert i tabellen. 2.3.

Tabell 2.3

Beslutning. Betegn - gjennomsnittlig antall besøkende til den th butikken per dag, tusen mennesker.

For å bestemme formen på den funksjonelle sammenhengen mellom variablene og konstruere et spredningsplott (fig. 2.2).

Basert på spredningsdiagrammet kan vi konkludere med at den årlige omsetningen er positivt relatert til gjennomsnittlig antall besøkende per dag (dvs. y vil øke med veksten på ). Formen for funksjonell avhengighet er lineær.

Ris. 2.2. Scatterplot for eksempel 2.2

Tabell 2.4

Generelt er det nødvendig å bestemme parametrene til den to-faktor økonometriske modellen

y t \u003d a 0 + a 1 x 1 t + a 2 x 2 t + ε t

Informasjonen som kreves for videre beregninger er presentert i tabell. 2.4.

La oss estimere parametrene til en lineær to-faktor økonometrisk modell ved å bruke minste kvadraters metode.

Og dermed,

Evaluering av koeffisienten = 61,6583 viser at, alt annet likt, med en økning i salgsarealet med 1 tusen m 2, vil den årlige omsetningen øke med gjennomsnittlig 61,6583 millioner rubler.

Vi tilnærmer funksjonen med et polynom av 2. grad. For å gjøre dette, beregner vi koeffisientene til det normale ligningssystemet:

,  ,

,

La oss komponere et normalt system av minste kvadrater, som har formen:

Løsningen til systemet er lett å finne:, , .

Dermed er polynomet av 2. grad funnet: .

Teoretisk referanse

Tilbake til siden<Введение в вычислительную математику. Примеры>

Eksempel 2. Finne den optimale graden av et polynom.

Tilbake til siden<Введение в вычислительную математику. Примеры>

Eksempel 3. Utledning av et normalt ligningssystem for å finne parametrene til en empirisk avhengighet.

La oss utlede et likningssystem for å bestemme koeffisientene og funksjonene ![]() , som utfører rot-middel-kvadrat-tilnærmingen til den gitte funksjonen med hensyn til poeng. Lag en funksjon

, som utfører rot-middel-kvadrat-tilnærmingen til den gitte funksjonen med hensyn til poeng. Lag en funksjon ![]() og skriv den nødvendige ekstremumbetingelsen for det:

og skriv den nødvendige ekstremumbetingelsen for det:

Da vil det vanlige systemet ha formen:

Vi har fått et lineært ligningssystem for ukjente parametere og, som er lett å løse.

Teoretisk referanse

Tilbake til siden<Введение в вычислительную математику. Примеры>

Eksempel.

Eksperimentelle data om verdiene til variabler X og på er gitt i tabellen.

Som et resultat av deres justering, funksjonen ![]()

Ved hjelp av minste kvadrat-metoden, tilnærme disse dataene med en lineær avhengighet y=ax+b(finn alternativer en og b). Finn ut hvilken av de to linjene som er best (i betydningen minste kvadraters metode) som justerer eksperimentelle data. Lag en tegning.

Essensen av metoden for minste kvadrater (LSM).

Problemet er å finne de lineære avhengighetskoeffisientene som funksjonen til to variabler en og b![]() tar den minste verdien. Det vil si gitt dataene en og b summen av de kvadrerte avvikene til eksperimentelle data fra den funnet rette linjen vil være den minste. Dette er hele poenget med minste kvadraters metode.

tar den minste verdien. Det vil si gitt dataene en og b summen av de kvadrerte avvikene til eksperimentelle data fra den funnet rette linjen vil være den minste. Dette er hele poenget med minste kvadraters metode.

Dermed er løsningen av eksempelet redusert til å finne ekstremumet til en funksjon av to variabler.

Utledning av formler for å finne koeffisienter.

Et system med to ligninger med to ukjente er kompilert og løst. Finne partielle deriverte av funksjoner ![]() etter variabler en og b, likestiller vi disse derivatene til null.

etter variabler en og b, likestiller vi disse derivatene til null.

Vi løser det resulterende ligningssystemet ved hjelp av en hvilken som helst metode (for eksempel substitusjonsmetode eller Cramers metode) og få formler for å finne koeffisienter ved å bruke minste kvadraters metode (LSM).

Med data en og b funksjon ![]() tar den minste verdien. Beviset for dette er gitt nedenfor i teksten på slutten av siden.

tar den minste verdien. Beviset for dette er gitt nedenfor i teksten på slutten av siden.

Det er hele metoden med minste kvadrater. Formel for å finne parameteren en inneholder summene , , og parameteren n er mengden eksperimentelle data. Verdiene av disse summene anbefales å beregnes separat.

Koeffisient b funnet etter beregning en.

Det er på tide å huske det originale eksemplet.

Beslutning.

I vårt eksempel n=5. Vi fyller ut tabellen for å gjøre det lettere å beregne beløpene som er inkludert i formlene til de nødvendige koeffisientene.

Verdiene i den fjerde raden i tabellen oppnås ved å multiplisere verdiene i den andre raden med verdiene i den tredje raden for hvert tall Jeg.

Verdiene i den femte raden i tabellen oppnås ved å kvadrere verdiene i den andre raden for hvert tall Jeg.

Verdiene i den siste kolonnen i tabellen er summene av verdiene på tvers av radene.

Vi bruker formlene til minste kvadraters metode for å finne koeffisientene en og b. Vi erstatter i dem de tilsvarende verdiene fra den siste kolonnen i tabellen:

Derfor, y=0,165x+2,184 er den ønskede tilnærmede rette linjen.

Det gjenstår å finne ut hvilken av linjene y=0,165x+2,184 eller ![]() tilnærmer de opprinnelige dataene bedre, det vil si å lage et estimat ved å bruke minste kvadraters metode.

tilnærmer de opprinnelige dataene bedre, det vil si å lage et estimat ved å bruke minste kvadraters metode.

Estimering av feilen til minste kvadraters metode.

For å gjøre dette, må du beregne summene av kvadrerte avvik fra de opprinnelige dataene fra disse linjene ![]() og

og ![]() , tilsvarer den minste verdien linjen som best tilnærmer de opprinnelige dataene i form av minste kvadraters metode.

, tilsvarer den minste verdien linjen som best tilnærmer de opprinnelige dataene i form av minste kvadraters metode.

Siden , så linjen y=0,165x+2,184 tilnærmer de opprinnelige dataene bedre.

Grafisk illustrasjon av minste kvadraters metode (LSM).

Alt ser bra ut på listene. Den røde linjen er den funnet linjen y=0,165x+2,184, er den blå linjen ![]() , de rosa prikkene er de originale dataene.

, de rosa prikkene er de originale dataene.

Hva er det for, hva er alle disse tilnærmingene til?

Jeg bruker personlig til å løse datautjevningsproblemer, interpolasjons- og ekstrapolasjonsproblemer (i det originale eksemplet kan du bli bedt om å finne verdien av den observerte verdien y på x=3 eller når x=6 i henhold til MNC-metoden). Men vi vil snakke mer om dette senere i en annen del av nettstedet.

Toppen av siden

Bevis.

Så når funnet en og b funksjonen tar den minste verdien, er det nødvendig at på dette tidspunktet matrisen til kvadratisk form av andreordens differensial for funksjonen ![]() var positiv definitivt. La oss vise det.

var positiv definitivt. La oss vise det.

Den andre ordensdifferensialen har formen:

Dvs

Derfor har matrisen til den kvadratiske formen formen

og verdiene til elementene avhenger ikke av en og b.

La oss vise at matrisen er positiv bestemt. Dette krever at vinkelminorene er positive.

Kantet moll av første orden  . Ulikheten er streng, siden punktene ikke er sammenfallende. Dette vil bli antydet i det følgende.

. Ulikheten er streng, siden punktene ikke er sammenfallende. Dette vil bli antydet i det følgende.

Kantet moll av andre orden

La oss bevise det  metode for matematisk induksjon.

metode for matematisk induksjon.

Konklusjon: funnet verdier en og b tilsvarer den minste verdien av funksjonen ![]() , derfor er de ønskede parameterne for minste kvadraters metode.

, derfor er de ønskede parameterne for minste kvadraters metode.

Har du noen gang forstått?

Bestill en løsning

Toppen av siden

Utvikling av en prognose ved hjelp av minste kvadraters metode. Eksempel på problemløsning

Ekstrapolering — Dette er en metode for vitenskapelig forskning, som er basert på formidling av tidligere og nåværende trender, mønstre, forhold til fremtidig utvikling av prognoseobjektet. Ekstrapoleringsmetoder inkluderer glidende gjennomsnittsmetode, eksponentiell utjevningsmetode, minste kvadraters metode.

Essens minste kvadraters metode består i å minimere summen av kvadratavvik mellom de observerte og beregnede verdier. De beregnede verdiene er funnet i henhold til den valgte ligningen - regresjonsligningen. Jo mindre avstanden er mellom de faktiske verdiene og de beregnede, desto mer nøyaktig er prognosen basert på regresjonsligningen.

Den teoretiske analysen av essensen av fenomenet som studeres, hvor endringen vises av en tidsserie, tjener som grunnlag for å velge en kurve. Betraktninger om arten av veksten av nivåene i serien blir noen ganger tatt i betraktning. Så hvis veksten av produksjonen forventes i en aritmetisk progresjon, utføres utjevning i en rett linje. Hvis det viser seg at veksten er eksponentiell, bør utjevning gjøres i henhold til eksponentiell funksjon.

Arbeidsformelen til metoden for minste kvadrater : Y t+1 = a*X + b, hvor t + 1 er prognoseperioden; Уt+1 – antatt indikator; a og b er koeffisienter; X er et symbol på tid.

Koeffisientene a og b beregnes i henhold til følgende formler:

|

|

hvor, Uf - de faktiske verdiene for serien med dynamikk; n er antall nivåer i tidsserien;

Utjevningen av tidsserier med minste kvadraters metode tjener til å reflektere utviklingsmønstrene til fenomenet som studeres. I det analytiske uttrykket av en trend betraktes tid som en uavhengig variabel, og nivåene i serien fungerer som en funksjon av denne uavhengige variabelen.

Utviklingen av et fenomen avhenger ikke av hvor mange år som har gått siden utgangspunktet, men av hvilke faktorer som påvirket utviklingen, i hvilken retning og med hvilken intensitet. Fra dette er det klart at utviklingen av et fenomen i tid vises som et resultat av virkningen av disse faktorene.

Korrekt innstilling av kurvetypen, typen analytisk avhengighet av tid er en av de vanskeligste oppgavene med pre-prediktiv analyse. .

Valget av typen funksjon som beskriver trenden, hvis parametere bestemmes av minste kvadraters metode, er i de fleste tilfeller empirisk, ved å konstruere en rekke funksjoner og sammenligne dem med hverandre når det gjelder verdien av roten -middel-kvadratfeil, beregnet ved formelen:

|

hvor Uf - de faktiske verdiene for serien med dynamikk; Ur – beregnede (utjevnede) verdier av tidsserien; n er antall nivåer i tidsserien; p er antall parametere definert i formlene som beskriver trenden (utviklingstrend).

Ulemper med minste kvadraters metode :

- når man prøver å beskrive det økonomiske fenomenet som studeres ved hjelp av en matematisk ligning, vil prognosen være nøyaktig i en kort periode, og regresjonsligningen bør beregnes på nytt etter hvert som ny informasjon blir tilgjengelig;

- kompleksiteten i utvalget av regresjonsligningen, som kan løses ved bruk av standard dataprogrammer.

Et eksempel på bruk av minste kvadraters metode for å utvikle en prognose

Oppgave . Det er data som karakteriserer nivået på arbeidsledigheten i regionen, %

- Bygg en prognose for arbeidsledigheten i regionen for månedene november, desember, januar, ved å bruke metodene: glidende gjennomsnitt, eksponentiell utjevning, minste kvadrater.

- Beregn feilene i de resulterende prognosene ved å bruke hver metode.

- Sammenlign de oppnådde resultatene, trekk konklusjoner.

Minste kvadraters løsning

For løsningen vil vi sette sammen en tabell der vi vil gjøre de nødvendige beregningene:

ε = 28,63/10 = 2,86 % prognosenøyaktighet høy.

Konklusjon : Sammenligning av resultatene oppnådd i beregningene glidende gjennomsnittsmetode , eksponensiell utjevning og minste kvadraters metode, kan vi si at den gjennomsnittlige relative feilen i beregninger ved eksponentiell utjevningsmetode faller innenfor 20-50 %. Dette betyr at prediksjonsnøyaktigheten i dette tilfellet bare er tilfredsstillende.

I det første og tredje tilfellet er prognosenøyaktigheten høy, siden den gjennomsnittlige relative feilen er mindre enn 10 %. Men metoden med glidende gjennomsnitt gjorde det mulig å oppnå mer pålitelige resultater (prognose for november - 1,52%, prognose for desember - 1,53%, prognose for januar - 1,49%), siden den gjennomsnittlige relative feilen ved bruk av denne metoden er den minste - 1 ,tretten%.

Minste kvadratiske metode

Andre relaterte artikler:

Liste over kilder som er brukt

- Vitenskapelige og metodiske anbefalinger om spørsmål om diagnostisering av sosiale risikoer og prognoser for utfordringer, trusler og sosiale konsekvenser. Russian State Social University. Moskva. 2010;

- Vladimirova L.P. Prognoser og planlegging under markedsforhold: Pros. godtgjørelse. M .: Publishing House "Dashkov and Co", 2001;

- Novikova N.V., Pozdeeva O.G. Forecasting the National Economy: Educational and Methodological Guide. Jekaterinburg: Forlag Ural. stat økonomi universitet, 2007;

- Slutskin L.N. MBA-kurs i forretningsprognoser. Moskva: Alpina Business Books, 2006.

MNE-program

Skriv inn data

Data og tilnærming y = a + b x

Jeg- nummer på forsøkspunktet;

x i- verdien av den faste parameteren på punktet Jeg;

y jeg- verdien av den målte parameteren på punktet Jeg;

ω i- Målevekt på punkt Jeg;

y i, beregnet.- forskjellen mellom den målte verdien og verdien beregnet fra regresjonen y på punktet Jeg;

S x i (x i)- feilestimat x i ved måling y på punktet Jeg.

Data og tilnærming y = k x

| Jeg | x i | y jeg | ω i | y i, beregnet. | Δy i | S x i (x i) |

|---|

Klikk på diagrammet

Brukerhåndbok for MNC online-programmet.

I datafeltet skriver du inn verdiene for "x" og "y" på hver separate linje på ett eksperimentelt punkt. Verdier må skilles med mellomrom (mellomrom eller tabulator).

Den tredje verdien kan være poengvekten til "w". Hvis punktvekten ikke er spesifisert, er den lik én. I det overveldende flertallet av tilfellene er vekten av forsøkspunktene ukjent eller ikke beregnet; alle eksperimentelle data anses som likeverdige. Noen ganger er vektene i det studerte verdiområdet definitivt ikke ekvivalente og kan til og med beregnes teoretisk. For eksempel, i spektrofotometri, kan vekter beregnes ved hjelp av enkle formler, selv om i utgangspunktet alle neglisjerer dette for å redusere arbeidskostnadene.

Data kan limes inn gjennom utklippstavlen fra et regneark for en kontorpakke, for eksempel Excel fra Microsoft Office eller Calc fra Open Office. For å gjøre dette, i regnearket, velg dataområdet som skal kopieres, kopier til utklippstavlen og lim inn dataene i datafeltet på denne siden.

For å beregne med minste kvadraters metode, kreves det minst to punkter for å bestemme to koeffisienter `b` - tangenten til helningsvinkelen til den rette linjen og `a` - verdien avskåret av den rette linjen på `y ` akse.

For å estimere feilen til de beregnede regresjonskoeffisientene, er det nødvendig å sette antall eksperimentelle punkter til mer enn to.

Minste kvadraters metode (LSM).

Jo større antall eksperimentelle poeng, desto mer nøyaktig er det statistiske estimatet av koeffisientene (på grunn av reduksjonen i elevens koeffisient) og jo nærmere estimatet er estimatet for det generelle utvalget.

Innhenting av verdier på hvert eksperimentelt punkt er ofte forbundet med betydelige arbeidskostnader, derfor blir det ofte utført et kompromiss antall eksperimenter, noe som gir et fordøyelig estimat og ikke fører til for høye arbeidskostnader. Som regel velges antall eksperimentelle punkter for en lineær minste kvadraters avhengighet med to koeffisienter i området 5-7 poeng.

En kort teori om minste kvadrater for lineær avhengighet

Anta at vi har et sett med eksperimentelle data i form av par med verdier [`y_i`, `x_i`], der `i` er tallet på én eksperimentell måling fra 1 til `n`; `y_i` - verdien av den målte verdien ved punktet `i`; `x_i` - verdien av parameteren vi satte i punktet `i`.

Et eksempel er driften av Ohms lov. Ved å endre spenningen (potensialforskjellen) mellom seksjoner av den elektriske kretsen, måler vi mengden strøm som går gjennom denne seksjonen. Fysikk gir oss avhengigheten funnet eksperimentelt:

`I=U/R`,

hvor `I` - strømstyrke; `R` - motstand; `U` - spenning.

I dette tilfellet er `y_i` den målte strømverdien, og `x_i` er spenningsverdien.

Som et annet eksempel, tenk på absorpsjonen av lys av en løsning av et stoff i løsning. Kjemi gir oss formelen:

`A = εl C`,

hvor "A" er den optiske tettheten til løsningen; `ε` - transmittans av oppløst stoff; `l` - banelengde når lys passerer gjennom en kyvette med en løsning; `C` er konsentrasjonen av det oppløste stoffet.

I dette tilfellet er `y_i` den målte optiske tettheten `A`, og `x_i` er konsentrasjonen av stoffet vi angir.

Vi vil vurdere tilfellet når den relative feilen ved innstilling av `x_i` er mye mindre enn den relative feilen ved måling av `y_i`. Vi vil også anta at alle målte verdier av `y_i` er tilfeldige og normalfordelte, dvs. overholde normalfordelingsloven.

I tilfellet med en lineær avhengighet av `y` av `x`, kan vi skrive den teoretiske avhengigheten:

`y = a + bx`.

Fra et geometrisk synspunkt angir koeffisienten "b" tangenten til helningsvinkelen til linjen til "x"-aksen, og koeffisienten "a" - verdien av "y" ved skjæringspunktet mellom linje med `y`-aksen (for `x = 0`).

Finne parametrene til regresjonslinjen.

I et eksperiment kan ikke de målte verdiene til `y_i` ligge nøyaktig på den teoretiske linjen på grunn av målefeil, som alltid er iboende i det virkelige liv. Derfor må en lineær ligning representeres av et ligningssystem:

`y_i = a + b x_i + ε_i` (1),

der "ε_i" er den ukjente målefeilen til "y" i det "i" eksperimentet.

Avhengighet (1) kalles også regresjon, dvs. avhengigheten av de to størrelsene av hverandre med statistisk signifikans.

Oppgaven med å gjenopprette avhengigheten er å finne koeffisientene `a` og `b` fra de eksperimentelle punktene [`y_i`, `x_i`].

For å finne koeffisientene brukes vanligvis `a` og `b` minste kvadrat-metoden(MNK). Det er et spesielt tilfelle av prinsippet om maksimal sannsynlighet.

La oss omskrive (1) som `ε_i = y_i - a - b x_i`.

Da blir summen av kvadrerte feil

`Φ = sum_(i=1)^(n) ε_i^2 = sum_(i=1)^(n) (y_i - a - b x_i)^2`. (2)

Prinsippet for minste kvadraters metode er å minimere summen (2) med hensyn til parameterne `a` og `b`.

Minimumet nås når de partielle deriverte av summen (2) med hensyn til koeffisientene `a` og `b` er lik null:

`frac(delvis Φ)(delvis a) = frac(delsum_(i=1)^(n) (y_i - a - b x_i)^2)(delvis a) = 0`

`frac(delvis Φ)(delvis b) = frac(delsum_(i=1)^(n) (y_i - a - b x_i)^2)(delvis b) = 0`

Ved å utvide de deriverte får vi et system med to ligninger med to ukjente:

`sum_(i=1)^(n) (2a + 2bx_i - 2y_i) = sum_(i=1)^(n) (a + bx_i - y_i) = 0`

`sum_(i=1)^(n) (2bx_i^2 + 2ax_i - 2x_iy_i) = sum_(i=1)^(n) (bx_i^2 + ax_i - x_iy_i) = 0`

Vi åpner parentesene og overfører summene uavhengig av de ønskede koeffisientene til den andre halvdelen, vi får et system med lineære ligninger:

`sum_(i=1)^(n) y_i = a n + b sum_(i=1)^(n) bx_i`

`sum_(i=1)^(n) x_iy_i = a sum_(i=1)^(n) x_i + b sum_(i=1)^(n) x_i^2`

Når vi løser det resulterende systemet, finner vi formler for koeffisientene `a` og `b`:

`a = frac(sum_(i=1)^(n) y_i sum_(i=1)^(n) x_i^2 - sum_(i=1)^(n) x_i sum_(i=1)^(n) ) x_iy_i) (n sum_(i=1)^(n) x_i^2 — (sum_(i=1)^(n) x_i)^2)` (3.1)

`b = frac(n sum_(i=1)^(n) x_iy_i - sum_(i=1)^(n) x_i sum_(i=1)^(n) y_i) (n sum_(i=1)^ (n) x_i^2 - (sum_(i=1)^(n) x_i)^2)` (3.2)

Disse formlene har løsninger når `n > 1` (linjen kan tegnes med minst 2 punkter) og når determinanten `D = n sum_(i=1)^(n) x_i^2 - (sum_(i= 1) )^(n) x_i)^2 != 0`, dvs. når «x_i»-punktene i eksperimentet er forskjellige (dvs. når linjen ikke er vertikal).

Estimering av feil i koeffisientene til regresjonslinjen

For et mer nøyaktig estimat av feilen ved beregning av koeffisientene `a` og `b`, er et stort antall eksperimentelle punkter ønskelig. Når `n = 2`, er det umulig å estimere feilen til koeffisientene, fordi den tilnærmede linjen vil unikt gå gjennom to punkter.

Feilen til den tilfeldige variabelen "V" bestemmes lov om feilakkumulering

`S_V^2 = sum_(i=1)^p (frac(delvis f)(delvis z_i))^2 S_(z_i)^2`,

hvor `p` er antall `z_i`-parametere med `S_(z_i)`-feil som påvirker `S_V`-feilen;

`f` er en avhengighetsfunksjon av `V` på `z_i`.

La oss skrive loven om akkumulering av feil for feilen til koeffisientene `a` og `b`

`S_a^2 = sum_(i=1)^(n)(frac(delvis a)(delvis y_i))^2 S_(y_i)^2 + sum_(i=1)^(n)(frac(delvis a) )(delvis x_i))^2 S_(x_i)^2 = S_y^2 sum_(i=1)^(n)(frac(delvis a)(delvis y_i))^2 `,

`S_b^2 = sum_(i=1)^(n)(frac(delvis b)(delvis y_i))^2 S_(y_i)^2 + sum_(i=1)^(n)(frac(delvis b )(delvis x_i))^2 S_(x_i)^2 = S_y^2 sum_(i=1)^(n)(frac(delvis b)(delvis y_i))^2 `,

fordi `S_(x_i)^2 = 0` (vi har tidligere tatt forbehold om at feilen til `x` er ubetydelig).

`S_y^2 = S_(y_i)^2` - feilen (varians, kvadratisk standardavvik) i `y`-dimensjonen, forutsatt at feilen er enhetlig for alle `y`-verdier.

Ved å erstatte formler for å beregne `a` og `b` i de resulterende uttrykkene, får vi

`S_a^2 = S_y^2 frac(sum_(i=1)^(n) (sum_(i=1)^(n) x_i^2 - x_i sum_(i=1)^(n) x_i)^2 ) (D^2) = S_y^2 frac((n sum_(i=1)^(n) x_i^2 - (sum_(i=1)^(n) x_i)^2) sum_(i=1) ^(n) x_i^2) (D^2) = S_y^2 frac(sum_(i=1)^(n) x_i^2) (D)` (4.1)

`S_b^2 = S_y^2 frac(sum_(i=1)^(n) (n x_i - sum_(i=1)^(n) x_i)^2) (D^2) = S_y^2 frac( n (n sum_(i=1)^(n) x_i^2 - (sum_(i=1)^(n) x_i)^2)) (D^2) = S_y^2 frac(n) (D) ` (4.2)

I de fleste virkelige eksperimenter måles ikke verdien av "Sy". For å gjøre dette er det nødvendig å utføre flere parallelle målinger (eksperimenter) på ett eller flere punkter i planen, noe som øker tiden (og muligens kostnaden) for eksperimentet. Derfor antas det vanligvis at avviket til `y` fra regresjonslinjen kan betraktes som tilfeldig. Variansestimatet "y" i dette tilfellet beregnes ved hjelp av formelen.

`S_y^2 = S_(y, hvile)^2 = frac(sum_(i=1)^n (y_i - a - b x_i)^2) (n-2)".

Divisor `n-2` vises fordi vi har redusert antall frihetsgrader på grunn av beregningen av to koeffisienter for samme utvalg av eksperimentelle data.

Dette estimatet kalles også restvariansen i forhold til regresjonslinjen `S_(y, rest)^2`.

Vurderingen av koeffisientenes betydning foretas etter Studentens kriterium

`t_a = frac(|a|) (S_a)`, `t_b = frac(|b|) (S_b)`

Hvis de beregnede kriteriene `t_a`, `t_b` er mindre enn tabellkriteriene `t(P, n-2)`, anses det at den tilsvarende koeffisienten ikke er signifikant forskjellig fra null med en gitt sannsynlighet `P`.

For å vurdere kvaliteten på beskrivelsen av et lineært forhold, kan du sammenligne `S_(y, hvile)^2` og `S_(bar y)` i forhold til gjennomsnittet ved å bruke Fisher-kriteriet.

`S_(bar y) = frac(sum_(i=1)^n (y_i - bar y)^2) (n-1) = frac(sum_(i=1)^n (y_i - (sum_(i= 1)^n y_i) /n)^2) (n-1)` - utvalgsestimat av variansen til `y` i forhold til gjennomsnittet.

For å evaluere effektiviteten til regresjonsligningen for å beskrive avhengigheten, beregnes Fisher-koeffisienten

`F = S_(bar y) / S_(y, hvile)^2`,

som sammenlignes med den tabellformede Fisher-koeffisienten `F(p, n-1, n-2)`.

Hvis `F > F(P, n-1, n-2)`, regnes forskjellen mellom beskrivelsen av avhengigheten `y = f(x)` ved bruk av regresjonsligningen og beskrivelsen som bruker gjennomsnittet statistisk signifikant med sannsynlighet `P`. De. regresjonen beskriver avhengigheten bedre enn spredningen av `y` rundt gjennomsnittet.

Klikk på diagrammet

å legge til verdier til tabellen

Minste kvadratiske metode. Metoden med minste kvadrater betyr bestemmelse av ukjente parametere a, b, c, den aksepterte funksjonelle avhengigheten

Metoden med minste kvadrater betyr bestemmelse av ukjente parametere a, b, c,... akseptert funksjonell avhengighet

y = f(x,a,b,c,...),

som ville gi et minimum av middelkvadraten (variansen) av feilen

, (24)

, (24)

hvor x i, y i - sett med tallpar hentet fra eksperimentet.

Siden betingelsen for ekstremumet til en funksjon av flere variabler er betingelsen om at dens partielle deriverte er lik null, vil parametrene a, b, c,... bestemmes ut fra ligningssystemet:

; ; ; … (25)

Det må huskes at minste kvadraters metode brukes til å velge parametere etter funksjonens form y = f(x) definert.

Hvis det ut fra teoretiske betraktninger er umulig å trekke noen konklusjoner om hva den empiriske formelen bør være, må man ledes av visuelle representasjoner, først og fremst en grafisk representasjon av de observerte dataene.

I praksis, oftest begrenset til følgende typer funksjoner:

1) lineær ![]() ;

;

2) kvadratisk a .

Å velge type regresjonsfunksjon, dvs. typen av den betraktede modellen for avhengigheten av Y på X (eller X på Y), for eksempel en lineær modell y x = a + bx, er det nødvendig å bestemme de spesifikke verdiene til koeffisientene til modellen.

For forskjellige verdier av a og b er det mulig å bygge et uendelig antall avhengigheter av formen y x = a + bx, det vil si at det er et uendelig antall linjer på koordinatplanet, men vi trenger en slik avhengighet at tilsvarer de observerte verdiene på beste måte. Dermed er problemet redusert til valget av de beste koeffisientene.

Vi ser etter en lineær funksjon a + bx, kun basert på et visst antall tilgjengelige observasjoner. For å finne funksjonen som passer best til de observerte verdiene, bruker vi minste kvadraters metode.

Betegn: Y i - verdien beregnet av ligningen Y i =a+bx i . y i - målt verdi, ε i =y i -Y i - forskjell mellom de målte og beregnede verdier, ε i =y i -a-bx i.

Metoden med minste kvadrater krever at ε i, forskjellen mellom den målte y i og verdiene til Y i beregnet fra ligningen, er minimal. Derfor finner vi koeffisientene a og b slik at summen av de kvadrerte avvikene til de observerte verdiene fra verdiene på den rette regresjonslinjen er den minste:

Ved å undersøke denne funksjonen til argumentene a og ved hjelp av deriverte til et ekstremum, kan vi bevise at funksjonen får en minimumsverdi hvis koeffisientene a og b er løsninger av systemet:

(2)

(2)

Hvis vi deler begge sider av normallikningene med n, får vi:

Gitt at  (3)

(3)

Få  , herfra, ved å erstatte verdien av a i den første ligningen, får vi:

, herfra, ved å erstatte verdien av a i den første ligningen, får vi:

I dette tilfellet kalles b regresjonskoeffisienten; a kalles det frie medlem av regresjonsligningen og beregnes med formelen:

Den resulterende rette linjen er et estimat for den teoretiske regresjonslinjen. Vi har:

Så, ![]() er en lineær regresjonsligning.

er en lineær regresjonsligning.

Regresjon kan være direkte (b>0) og invers (b Eksempel 1. Resultatene av måling av X- og Y-verdiene er gitt i tabellen:

| x i | -2 | 0 | 1 | 2 | 4 |

| y jeg | 0.5 | 1 | 1.5 | 2 | 3 |

Forutsatt at det er en lineær sammenheng mellom X og Y y=a+bx, bestem koeffisientene a og b ved hjelp av minste kvadraters metode.

Beslutning. Her er n=5

xi = -2+0+1+2+4=5;

x i 2 =4+0+1+4+16=25

x i y i =-2 0,5+0 1+1 1,5+2 2+4 3=16,5

yi =0,5+1+1,5+2+3=8

og normalt system (2) har formen ![]()

Ved å løse dette systemet får vi: b=0,425, a=1,175. Derfor y=1,175+0,425x.

Eksempel 2. Det er et utvalg på 10 observasjoner av økonomiske indikatorer (X) og (Y).

| x i | 180 | 172 | 173 | 169 | 175 | 170 | 179 | 170 | 167 | 174 |

| y jeg | 186 | 180 | 176 | 171 | 182 | 166 | 182 | 172 | 169 | 177 |

Det er nødvendig å finne en prøveregresjonsligning Y på X. Konstruer en prøveregresjonslinje Y på X.

Beslutning. 1. La oss sortere dataene etter verdiene x i og y i . Vi får et nytt bord:

| x i | 167 | 169 | 170 | 170 | 172 | 173 | 174 | 175 | 179 | 180 |

| y jeg | 169 | 171 | 166 | 172 | 180 | 176 | 177 | 182 | 182 | 186 |

For å forenkle beregningene vil vi sette sammen en beregningstabell der vi legger inn nødvendige tallverdier.

| x i | y jeg | x i 2 | x i y i |

| 167 | 169 | 27889 | 28223 |

| 169 | 171 | 28561 | 28899 |

| 170 | 166 | 28900 | 28220 |

| 170 | 172 | 28900 | 29240 |

| 172 | 180 | 29584 | 30960 |

| 173 | 176 | 29929 | 30448 |

| 174 | 177 | 30276 | 30798 |

| 175 | 182 | 30625 | 31850 |

| 179 | 182 | 32041 | 32578 |

| 180 | 186 | 32400 | 33480 |

| ∑x i =1729 | ∑y i =1761 | ∑x i 2 299105 | ∑x i y i =304696 |

| x=172,9 | y=176,1 | x i 2 = 29910,5 | xy=30469,6 |

I henhold til formel (4) beregner vi regresjonskoeffisienten

og ved formel (5)

Dermed ser prøveregresjonsligningen ut som y=-59,34+1,3804x.

La oss plotte punktene (x i ; y i) på koordinatplanet og markere regresjonslinjen.

Fig 4

Figur 4 viser hvordan de observerte verdiene er lokalisert i forhold til regresjonslinjen. For å numerisk estimere avvikene til y i fra Y i , hvor y i er observerte verdier, og Y i er verdier bestemt av regresjon, vil vi lage en tabell:

| x i | y jeg | Y i | Y i -y i |

| 167 | 169 | 168.055 | -0.945 |

| 169 | 171 | 170.778 | -0.222 |

| 170 | 166 | 172.140 | 6.140 |

| 170 | 172 | 172.140 | 0.140 |

| 172 | 180 | 174.863 | -5.137 |

| 173 | 176 | 176.225 | 0.225 |

| 174 | 177 | 177.587 | 0.587 |

| 175 | 182 | 178.949 | -3.051 |

| 179 | 182 | 184.395 | 2.395 |

| 180 | 186 | 185.757 | -0.243 |

Y i-verdier beregnes i henhold til regresjonsligningen.

Det merkbare avviket til noen observerte verdier fra regresjonslinjen forklares av det lille antallet observasjoner. Når man studerer graden av lineær avhengighet til Y av X, tas antall observasjoner i betraktning. Styrken på avhengigheten bestemmes av verdien av korrelasjonskoeffisienten.

Minste kvadratiske metode brukes til å estimere parametrene til regresjonsligningen.En av metodene for å studere stokastiske sammenhenger mellom funksjoner er regresjonsanalyse.

Regresjonsanalyse er utledningen av en regresjonsligning, som brukes til å finne gjennomsnittsverdien av en tilfeldig variabel (funksjon-resultat), hvis verdien av en annen (eller andre) variabler (funksjonsfaktorer) er kjent. Den inkluderer følgende trinn:

- valg av koblingsform (type analytisk regresjonsligning);

- estimering av ligningsparametere;

- evaluering av kvaliteten på den analytiske regresjonsligningen.

Ved en lineær parrelasjon vil regresjonsligningen ha formen: y i =a+b·x i +u i. Parametrene til denne ligningen a og b er estimert fra dataene fra statistiske observasjoner x og y. Resultatet av en slik vurdering er ligningen: , hvor , - estimater av parameterne a og b , - verdien av den effektive egenskapen (variabelen) oppnådd av regresjonsligningen (kalkulert verdi).

Den mest brukte for parameterestimering er minste kvadraters metode (LSM).

Minste kvadraters metode gir de beste (konsistente, effektive og objektive) estimatene av parametrene til regresjonsligningen. Men bare hvis visse forutsetninger om tilfeldigleddet (u) og den uavhengige variabelen (x) er oppfylt (se OLS-forutsetninger).

Problemet med å estimere parametrene til en lineær parligning ved minste kvadraters metode består i følgende: for å oppnå slike estimater av parameterne , , hvor summen av kvadrerte avvik av de faktiske verdiene til den effektive funksjonen - y i fra de beregnede verdiene - er minimal.

Formelt OLS-kriterium kan skrives slik:  .

.

Klassifisering av minste kvadraters metoder

- Minste kvadratiske metode.

- Maksimal sannsynlighetsmetode (for en normal klassisk lineær regresjonsmodell, postuleres normalitet av regresjonsresidier).

- Den generaliserte minste kvadraters metode for GLSM brukes i tilfelle av feil autokorrelasjon og i tilfelle av heteroskedastisitet.

- Vektet minste kvadraters metode (et spesialtilfelle av GLSM med heteroskedastiske residualer).

Illustrer essensen den klassiske metoden for minste kvadrater grafisk. For å gjøre dette skal vi bygge et punktplott i henhold til observasjonsdataene (x i , y i , i=1;n) i et rektangulært koordinatsystem (et slikt punktplott kalles et korrelasjonsfelt). La oss prøve å finne en rett linje som er nærmest punktene i korrelasjonsfeltet. I henhold til minste kvadraters metode er linjen valgt slik at summen av kvadratiske vertikale avstander mellom punktene i korrelasjonsfeltet og denne linjen blir minimal.

Matematisk notasjon av dette problemet:  .

.

Verdiene til y i og x i =1...n er kjent for oss, dette er observasjonsdata. I funksjonen S er de konstanter. Variablene i denne funksjonen er de nødvendige estimatene for parameterne - , . For å finne minimum av en funksjon av 2 variabler, er det nødvendig å beregne de partielle deriverte av denne funksjonen med hensyn til hver av parameterne og likestille dem til null, dvs.  .

.

Som et resultat får vi et system med 2 normale lineære ligninger:

Ved å løse dette systemet finner vi de nødvendige parameterestimatene:

Riktigheten av beregningen av parametrene til regresjonsligningen kan kontrolleres ved å sammenligne summene (noe avvik er mulig på grunn av avrunding av beregningene).

For å beregne parameteranslag kan du bygge tabell 1.

Tegnet til regresjonskoeffisienten b indikerer retningen til sammenhengen (hvis b > 0, er sammenhengen direkte, hvis b<0, то связь обратная). Величина b показывает на сколько единиц изменится в среднем признак-результат -y при изменении признака-фактора - х на 1 единицу своего измерения.

Formelt sett er verdien av parameteren a gjennomsnittsverdien av y for x lik null. Hvis fortegnsfaktoren ikke har og ikke kan ha en nullverdi, gir ikke tolkningen ovenfor av parameteren a mening.

Vurdering av tettheten i forholdet mellom funksjoner

utføres ved å bruke koeffisienten for lineær parkorrelasjon - r x,y . Det kan beregnes ved hjelp av formelen:  . I tillegg kan koeffisienten for lineær parkorrelasjon bestemmes i form av regresjonskoeffisienten b:

. I tillegg kan koeffisienten for lineær parkorrelasjon bestemmes i form av regresjonskoeffisienten b:  .

.

Utvalget av tillatte verdier for den lineære koeffisienten av parkorrelasjon er fra –1 til +1. Tegnet på korrelasjonskoeffisienten indikerer retningen av forholdet. Hvis r x, y >0, så er forbindelsen direkte; hvis r x, y<0, то связь обратная.

Hvis denne koeffisienten er nær enhet i modul, kan forholdet mellom funksjonene tolkes som en ganske nær lineær. Hvis dens modul er lik én ê r x , y ê =1, så er forholdet mellom egenskapene funksjonelt lineært. Hvis funksjonene x og y er lineært uavhengige, er r x,y nær 0.

Tabell 1 kan også brukes til å beregne r x,y.

For å vurdere kvaliteten på den oppnådde regresjonsligningen, beregnes den teoretiske bestemmelseskoeffisienten - R 2 yx:  ,

,

hvor d 2 er variansen y forklart av regresjonsligningen;

e 2 - residual (uforklart av regresjonsligningen) varians y ;

s 2 y - total (total) varians y .

Bestemmelseskoeffisienten karakteriserer andelen variasjon (spredning) av den resulterende egenskapen y, forklart ved regresjon (og følgelig faktoren x), i den totale variasjonen (spredningen) y. Bestemmelseskoeffisienten R 2 yx tar verdier fra 0 til 1. Følgelig karakteriserer verdien 1-R 2 yx andelen varians y forårsaket av påvirkning av andre faktorer som ikke er tatt i betraktning i modellen og spesifikasjonsfeil.

Med paret lineær regresjon R 2 yx =r 2 yx .

Minste kvadratiske metode

Minste kvadratiske metode ( MNK, OLS, Vanlige minste kvadrater) - en av de grunnleggende metodene for regresjonsanalyse for å estimere ukjente parametere for regresjonsmodeller fra prøvedata. Metoden er basert på å minimere summen av kvadrater av regresjonsrester.

Det skal bemerkes at selve minste kvadraters metoden kan kalles en metode for å løse et problem i et hvilket som helst område dersom løsningen består av eller tilfredsstiller et visst kriterium for å minimere kvadratsummen av noen funksjoner til de ukjente variablene. Derfor kan minste kvadraters metode også brukes for en omtrentlig representasjon (tilnærming) av en gitt funksjon ved hjelp av andre (enklere) funksjoner, når man finner et sett med mengder som tilfredsstiller ligninger eller restriksjoner, hvis antall overstiger antallet av disse mengdene , etc.

Essensen av MNC

La en (parametrisk) modell av sannsynlighet (regresjon) avhengighet mellom den (forklarte) variabelen y og mange faktorer (forklarende variabler) x

hvor er vektoren av ukjente modellparametere

- Tilfeldig modellfeil.La det også være prøveobservasjoner av verdiene til de angitte variablene. La være observasjonsnummeret (). Deretter er verdiene til variablene i den -te observasjonen. Deretter, for gitte verdier av parameterne b, er det mulig å beregne de teoretiske (modell) verdiene til den forklarte variabelen y:

Verdien av residualene avhenger av verdiene til parameterne b.

Essensen av LSM (vanlig, klassisk) er å finne slike parametere b som summen av kvadratene til residualene (eng. Restsum av kvadrater) vil være minimal:

I det generelle tilfellet kan dette problemet løses med numeriske metoder for optimalisering (minimering). I dette tilfellet snakker man om ikke-lineære minste kvadrater(NLS eller NLLS - engelsk. Ikke-lineære minste kvadrater). I mange tilfeller kan en analytisk løsning oppnås. For å løse minimeringsproblemet er det nødvendig å finne de stasjonære punktene til funksjonen ved å differensiere den med hensyn til de ukjente parameterne b, likestille de deriverte til null og løse det resulterende ligningssystemet:

Hvis de tilfeldige feilene i modellen er normalfordelt, har samme varians og ikke er korrelert med hverandre, er estimatene for minste kvadraters parameter de samme som estimatene for maksimum sannsynlighetsmetoden (MLM).

LSM i tilfelle av en lineær modell

La regresjonsavhengigheten være lineær:

La være y- kolonnevektor for observasjoner av den forklarte variabelen, og - matrise av faktorobservasjoner (rader av matrisen - vektorer av faktorverdier i en gitt observasjon, etter kolonner - vektor av verdier for en gitt faktor i alle observasjoner). Matrisepresentasjonen av den lineære modellen har formen:

Da vil vektoren for estimater for den forklarte variabelen og vektoren for regresjonsresidier være lik

følgelig vil summen av kvadratene til regresjonsrestene være lik

Ved å differensiere denne funksjonen med hensyn til parametervektoren og likestille de deriverte til null, får vi et system av ligninger (i matriseform):

.Løsningen av dette ligningssystemet gir den generelle formelen for minste kvadraters estimater for den lineære modellen:

For analytiske formål viser den siste representasjonen av denne formelen seg å være nyttig. Hvis dataene i regresjonsmodellen sentrert, så i denne representasjonen har den første matrisen betydningen av en prøve kovariansmatrise av faktorer, og den andre er vektoren av kovarianser av faktorer med en avhengig variabel. Hvis i tillegg dataene også er normalisert på SKO (det vil si til syvende og sist standardisert), så har den første matrisen betydningen av prøvekorrelasjonsmatrisen av faktorer, den andre vektoren - vektoren av prøvekorrelasjoner av faktorer med den avhengige variabelen.

En viktig egenskap ved LLS-estimater for modeller med en konstant- linjen til den konstruerte regresjonen går gjennom tyngdepunktet til prøvedataene, det vil si at likheten er oppfylt:

Spesielt i det ekstreme tilfellet, når den eneste regressoren er en konstant, finner vi at OLS-estimatet for en enkelt parameter (konstanten i seg selv) er lik middelverdien til variabelen som forklares. Det vil si at det aritmetiske gjennomsnittet, kjent for sine gode egenskaper fra lovene for store tall, også er et minstekvadrat-estimat - det tilfredsstiller kriteriet for minimumssummen av kvadrerte avvik fra det.

Eksempel: enkel (parvis) regresjon

Når det gjelder paret lineær regresjon, er beregningsformlene forenklet (du kan klare deg uten matrisealgebra):

Egenskaper til OLS-estimater

Først av alt, merker vi at for lineære modeller er minste kvadraters estimater lineære estimater, som følger av formelen ovenfor. For objektive OLS-estimater er det nødvendig og tilstrekkelig å oppfylle den viktigste betingelsen for regresjonsanalyse: betinget av faktorene må den matematiske forventningen til en tilfeldig feil være lik null. Denne betingelsen er oppfylt, spesielt hvis

- den matematiske forventningen til tilfeldige feil er null, og

- faktorer og tilfeldige feil er uavhengige tilfeldige variabler.

Den andre tilstanden - tilstanden til eksogene faktorer - er grunnleggende. Hvis denne egenskapen ikke er fornøyd, kan vi anta at nesten alle estimater vil være ekstremt utilfredsstillende: de vil ikke engang være konsistente (det vil si at selv en veldig stor mengde data ikke tillater å oppnå kvalitative estimater i dette tilfellet). I det klassiske tilfellet gjøres det en sterkere antagelse om faktorers determinisme, i motsetning til en tilfeldig feil, som automatisk betyr at den eksogene betingelsen er oppfylt. I det generelle tilfellet, for konsistensen av estimatene, er det tilstrekkelig å oppfylle eksogenitetsbetingelsen sammen med konvergensen av matrisen til en ikke-singular matrise med en økning i prøvestørrelsen til uendelig.

For at, i tillegg til konsistens og upartiskhet, de (vanlige) minste kvadraters estimatene også skal være effektive (de beste i klassen av lineære objektive estimater), må tilleggsegenskapene til en tilfeldig feil være tilfredsstilt:

Disse forutsetningene kan formuleres for kovariansmatrisen til den tilfeldige feilvektoren

En lineær modell som tilfredsstiller disse betingelsene kalles klassisk. OLS estimater for klassisk lineær regresjon er objektive, konsistente og mest effektive estimater i klassen av alle lineære upartiske estimater (i engelsk litteratur brukes forkortelsen noen ganger blå (Beste lineære ugrunnlagde estimator) er det beste lineære objektive estimatet; i innenlandsk litteratur blir Gauss-Markov-teoremet oftere sitert). Som det er lett å vise, vil kovariansmatrisen til koeffisientestimatvektoren være lik:

Generaliserte minste kvadrater

Metoden med minste kvadrater tillater en bred generalisering. I stedet for å minimere summen av kvadrater av residualene, kan man minimere en positiv bestemt kvadratisk form av restvektoren , hvor er en symmetrisk positiv bestemt vektmatrise. Vanlige minste kvadrater er et spesielt tilfelle av denne tilnærmingen, når vektmatrisen er proporsjonal med identitetsmatrisen. Som kjent fra teorien om symmetriske matriser (eller operatorer), er det en dekomponering for slike matriser. Derfor kan den spesifiserte funksjonelle representeres som følger, det vil si at denne funksjonelle kan representeres som summen av kvadratene til noen transformerte "rester". Dermed kan vi skille en klasse av minste kvadraters metoder - LS-metoder (minste kvadrater).

Det er bevist (Aitkens teorem) at for en generalisert lineær regresjonsmodell (der ingen restriksjoner er pålagt kovariansmatrisen av tilfeldige feil), er de mest effektive (i klassen av lineære objektive estimater) estimater av såkalte. generalisert OLS (OMNK, GLS - generaliserte minste kvadrater)- LS-metode med en vektmatrise lik den inverse kovariansmatrisen av tilfeldige feil: .

Det kan vises at formelen for GLS-estimatene for parameterne til den lineære modellen har formen

Kovariansmatrisen til disse estimatene vil henholdsvis være lik

Faktisk ligger essensen av OLS i en viss (lineær) transformasjon (P) av de opprinnelige dataene og bruken av de vanlige minste kvadrater på de transformerte dataene. Hensikten med denne transformasjonen er at for de transformerte dataene tilfredsstiller de tilfeldige feilene allerede de klassiske forutsetningene.

Vekte minste kvadrater

Når det gjelder en diagonal vektmatrise (og derav kovariansmatrisen av tilfeldige feil), har vi de såkalte vektet minste kvadrater (WLS – Weighted Least Squares). I dette tilfellet minimeres den vektede summen av kvadrater av residualene til modellen, det vil si at hver observasjon mottar en "vekt" som er omvendt proporsjonal med variansen til den tilfeldige feilen i denne observasjonen: . Faktisk transformeres dataene ved å vekte observasjonene (diving med en mengde proporsjonal med det antatte standardavviket til de tilfeldige feilene), og normale minste kvadrater brukes på de vektede dataene.

Noen spesielle tilfeller av anvendelse av LSM i praksis

Lineær tilnærming

Tenk på tilfellet når, som et resultat av å studere avhengigheten av en viss skalar mengde av en viss skalar mengde (Dette kan for eksempel være avhengigheten av spenning på strømstyrken: , hvor er en konstant verdi, motstanden til lederen ), ble disse mengdene målt, som et resultat av at verdiene ble oppnådd deres tilsvarende verdier. Måledata skal registreres i en tabell.

Bord. Måleresultater.

| Mål nr. | ||

|---|---|---|

| 1 | ||

| 2 | ||

| 3 | ||

| 4 | ||

| 5 | ||

| 6 |

Spørsmålet lyder slik: hvilken verdi av koeffisienten kan velges for best å beskrive avhengigheten? I følge LSM skal denne verdien være slik at summen av kvadrerte avvik av verdiene fra verdiene

var minimal

Summen av kvadrerte avvik har ett ekstremum - et minimum, som lar oss bruke denne formelen. La oss finne verdien av koeffisienten fra denne formelen. For å gjøre dette transformerer vi venstre side som følger:

Den siste formelen lar oss finne verdien av koeffisienten , som var nødvendig i oppgaven.

Historie

Fram til begynnelsen av XIX århundre. forskere hadde ikke visse regler for å løse et ligningssystem der antallet ukjente er mindre enn antallet ligninger; Inntil den tid ble spesielle metoder brukt, avhengig av type ligninger og på oppfinnsomheten til kalkulatorer, og derfor kom forskjellige kalkulatorer, med utgangspunkt i de samme observasjonsdataene, til forskjellige konklusjoner. Gauss (1795) er kreditert med den første anvendelsen av metoden, og Legendre (1805) oppdaget og publiserte den uavhengig under sitt moderne navn (fr. Methode des moindres quarres ). Laplace relaterte metoden til sannsynlighetsteorien, og den amerikanske matematikeren Adrain (1808) vurderte dens sannsynlige anvendelser. Metoden er utbredt og forbedret ved videre forskning av Encke, Bessel, Hansen og andre.

Alternativ bruk av MNC

Ideen om minste kvadraters metode kan også brukes i andre tilfeller som ikke er direkte relatert til regresjonsanalyse. Faktum er at summen av kvadrater er et av de vanligste nærhetsmålene for vektorer (den euklidiske metrikken i endelig-dimensjonale rom).

En applikasjon er å "løse" systemer av lineære ligninger der antallet ligninger er større enn antallet variabler

hvor matrisen ikke er kvadratisk, men rektangulær.

Et slikt ligningssystem har i det generelle tilfellet ingen løsning (hvis rangeringen faktisk er større enn antall variabler). Derfor kan dette systemet bare "løses" i betydningen å velge en slik vektor for å minimere "avstanden" mellom vektorene og . For å gjøre dette kan du bruke kriteriet for å minimere summen av kvadratiske forskjeller til venstre og høyre del av likningene til systemet, det vil si . Det er lett å vise at løsningen av dette minimeringsproblemet fører til løsningen av følgende ligningssystem