Методът на най-малките квадрати е изграден върху условието. Къде се прилага методът на най-малките квадрати?

Методът на най-малките квадрати е един от най-разпространените и най-разработени поради своята простота и ефективност на методите за оценка на параметрите на линейни. В същото време трябва да се спазва известна предпазливост при използването му, тъй като моделите, изградени с него, може да не отговарят на редица изисквания за качеството на техните параметри и в резултат на това да не отразяват „добре“ моделите на развитие на процеса.

Нека разгледаме по-подробно процедурата за оценка на параметрите на линеен иконометричен модел по метода на най-малките квадрати. Такъв модел в общ вид може да бъде представен с уравнение (1.2):

y t = a 0 + a 1 x 1 t +...+ a n x nt + ε t .

Първоначалните данни при оценка на параметрите a 0 , a 1 ,..., a n са векторът на стойностите на зависимата променлива г= (y 1 , y 2 , ... , y T)" и матрицата на стойностите на независимите променливи

в която първата колона, състояща се от единици, съответства на коефициента на модела .

Методът на най-малките квадрати получи името си въз основа на основния принцип, че получените въз основа на него оценки на параметрите трябва да отговарят на: сумата от квадратите на грешката на модела трябва да бъде минимална.

Примери за решаване на задачи по метода на най-малките квадрати

Пример 2.1.Търговското предприятие разполага с мрежа от 12 магазина, информация за дейността на които е представена в табл. 2.1.

Ръководството на компанията би искало да знае как размерът на годишния зависи от търговската площ на магазина.

Таблица 2.1

|

Номер на магазина |

Годишен оборот, милиони рубли |

Търговска площ, хиляди m 2 |

Решение на най-малките квадрати.Нека посочим - годишния оборот на -ти магазин, милиони рубли; - продажна площ на -ти магазин, хил. м 2.

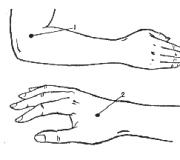

Фиг.2.1. Диаграма на разсейване за пример 2.1

Да се определи формата на функционалната връзка между променливите и да се построи диаграма на разсейване (фиг. 2.1).

Въз основа на диаграмата на разсейване можем да заключим, че годишният оборот зависи положително от района на продажба (т.е. y ще се увеличава с нарастването на ). Най-подходящата форма на функционална връзка е − линеен.

Информацията за по-нататъшни изчисления е представена в табл. 2.2. Използвайки метода на най-малките квадрати, ние оценяваме параметрите на линейния еднофакторен иконометричен модел

Таблица 2.2

По този начин,

Следователно, с увеличаване на търговската площ с 1 хил. m 2, при равни други условия, средният годишен оборот се увеличава с 67,8871 милиона рубли.

Пример 2.2.Ръководството на предприятието забеляза, че годишният оборот зависи не само от търговската площ на магазина (виж пример 2.1), но и от средния брой посетители. Съответната информация е представена в табл. 2.3.

Таблица 2.3

Решение.Означете - средният брой посетители на ия магазин на ден, хиляди души.

Да се определи формата на функционалната връзка между променливите и да се построи диаграма на разсейване (фиг. 2.2).

Въз основа на диаграмата на разсейване можем да заключим, че годишният оборот е положително свързан със средния брой посетители на ден (т.е. y ще се увеличава с нарастването на ). Формата на функционалната зависимост е линейна.

Ориз. 2.2. Диаграма на разсейване например 2.2

Таблица 2.4

Като цяло е необходимо да се определят параметрите на двуфакторния иконометричен модел

y t \u003d a 0 + a 1 x 1 t + a 2 x 2 t + ε t

Информацията, необходима за по-нататъшни изчисления, е представена в табл. 2.4.

Нека оценим параметрите на линеен двуфакторен иконометричен модел, използвайки метода на най-малките квадрати.

По този начин,

Оценката на коефициента = 61,6583 показва, че при равни други условия с увеличаване на търговската площ с 1 хил. m 2 годишният оборот ще се увеличи средно с 61,6583 милиона рубли.

Приближаваме функцията с полином от 2-ра степен. За да направите това, изчисляваме коефициентите на нормалната система от уравнения:

,  ,

,

Нека съставим нормална система от най-малки квадрати, която има формата:

Решението на системата е лесно да се намери:, , .

Така се намира полиномът от 2-ра степен: .

Теоретична справка

Обратно към страницата<Введение в вычислительную математику. Примеры>

Пример 2. Намиране на оптималната степен на полином.

Обратно към страницата<Введение в вычислительную математику. Примеры>

Пример 3. Извеждане на нормална система от уравнения за намиране на параметрите на емпирична зависимост.

Нека изведем система от уравнения за определяне на коефициентите и функциите ![]() , който извършва средноквадратната апроксимация на дадената функция по отношение на точки. Съставяне на функция

, който извършва средноквадратната апроксимация на дадената функция по отношение на точки. Съставяне на функция ![]() и напишете необходимото екстремно условие за него:

и напишете необходимото екстремно условие за него:

Тогава нормалната система ще приеме формата:

Получихме линейна система от уравнения за неизвестни параметри и, която лесно се решава.

Теоретична справка

Обратно към страницата<Введение в вычислительную математику. Примеры>

Пример.

Експериментални данни за стойностите на променливите хи вса дадени в таблицата.

В резултат на тяхното подравняване, функцията ![]()

Използвайки метод на най-малкия квадрат, апроксимирайте тези данни с линейна зависимост y=ax+b(намерете опции аи б). Разберете коя от двете линии е по-добра (в смисъл на метода на най-малките квадрати) подравнява експерименталните данни. Направете чертеж.

Същността на метода на най-малките квадрати (LSM).

Проблемът е да се намерят коефициентите на линейна зависимост, за които е функцията на две променливи аи б![]() приема най-малката стойност. Тоест предвид данните аи бсумата от квадратите отклонения на експерименталните данни от намерената права линия ще бъде най-малката. Това е целият смисъл на метода на най-малките квадрати.

приема най-малката стойност. Тоест предвид данните аи бсумата от квадратите отклонения на експерименталните данни от намерената права линия ще бъде най-малката. Това е целият смисъл на метода на най-малките квадрати.

Така решението на примера се свежда до намиране на екстремума на функция от две променливи.

Извеждане на формули за намиране на коефициенти.

Съставя се и се решава система от две уравнения с две неизвестни. Намиране на частни производни на функции ![]() чрез променливи аи б, ние приравняваме тези производни към нула.

чрез променливи аи б, ние приравняваме тези производни към нула.

Решаваме получената система от уравнения по всеки метод (напр метод на заместванеили метод на Крамер) и да получите формули за намиране на коефициенти по метода на най-малките квадрати (LSM).

С данни аи бфункция ![]() приема най-малката стойност. Доказателството за този факт е дадено по-долу в текста в края на страницата.

приема най-малката стойност. Доказателството за този факт е дадено по-долу в текста в края на страницата.

Това е целият метод на най-малките квадрати. Формула за намиране на параметъра асъдържа сумите , , , и параметъра не количеството експериментални данни. Стойностите на тези суми се препоръчва да се изчисляват отделно.

Коефициент бнамерено след изчисление а.

Време е да си спомним оригиналния пример.

Решение.

В нашия пример n=5. Попълваме таблицата за удобство при изчисляване на сумите, които са включени във формулите на необходимите коефициенти.

Стойностите в четвъртия ред на таблицата се получават чрез умножаване на стойностите на 2-ри ред по стойностите на 3-ти ред за всяко число и.

Стойностите в петия ред на таблицата се получават чрез квадратура на стойностите на 2-ри ред за всяко число и.

Стойностите на последната колона на таблицата са сумите от стойностите в редовете.

Използваме формулите на метода на най-малките квадрати, за да намерим коефициентите аи б. Заместваме в тях съответните стойности от последната колона на таблицата:

следователно, y=0,165x+2,184е желаната приближаваща права линия.

Остава да разберем коя от линиите y=0,165x+2,184или ![]() приближава по-добре оригиналните данни, т.е. да направи оценка, използвайки метода на най-малките квадрати.

приближава по-добре оригиналните данни, т.е. да направи оценка, използвайки метода на най-малките квадрати.

Оценка на грешката на метода на най-малките квадрати.

За да направите това, трябва да изчислите сумите на квадратните отклонения на оригиналните данни от тези редове ![]() и

и ![]() , по-малката стойност съответства на линията, която най-добре приближава оригиналните данни по отношение на метода на най-малките квадрати.

, по-малката стойност съответства на линията, която най-добре приближава оригиналните данни по отношение на метода на най-малките квадрати.

Тъй като , тогава линията y=0,165x+2,184приближава по-добре оригиналните данни.

Графична илюстрация на метода на най-малките квадрати (LSM).

Всичко изглежда страхотно на класациите. Червената линия е намерената линия y=0,165x+2,184, синята линия е ![]() , розовите точки са оригиналните данни.

, розовите точки са оригиналните данни.

За какво е, за какво са всички тези приближения?

Аз лично използвам за решаване на проблеми с изглаждането на данни, проблеми с интерполация и екстраполация (в оригиналния пример може да бъдете помолени да намерите стойността на наблюдаваната стойност гв х=3или кога х=6по метода на MNC). Но ще говорим повече за това по-късно в друг раздел на сайта.

Най-горе на страницата

Доказателство.

Така че когато се намери аи бфункцията приема най-малката стойност, е необходимо в този момент матрицата на квадратната форма на диференциала от втори ред за функцията ![]() беше положително определено. Нека го покажем.

беше положително определено. Нека го покажем.

Диференциалът от втори ред има формата:

т.е

Следователно, матрицата на квадратната форма има формата

и стойностите на елементите не зависят от аи б.

Нека покажем, че матрицата е положително определена. Това изисква минорите на ъгъла да са положителни.

Ъглов минор от първи ред  . Неравенството е строго, тъй като точките не съвпадат. Това ще се подразбира в това, което следва.

. Неравенството е строго, тъй като точките не съвпадат. Това ще се подразбира в това, което следва.

Ъглов минор от втори ред

Нека докажем това  метод на математическа индукция.

метод на математическа индукция.

Заключение: намерени стойности аи бсъответстват на най-малката стойност на функцията ![]() следователно са желаните параметри за метода на най-малките квадрати.

следователно са желаните параметри за метода на най-малките квадрати.

Разбирате ли някога?

Поръчайте решение

Най-горе на страницата

Разработване на прогноза по метода на най-малките квадрати. Пример за решение на проблема

Екстраполация - това е метод на научно изследване, който се основава на разпространението на минали и настоящи тенденции, закономерности, връзки с бъдещото развитие на обекта на прогнозиране. Методите за екстраполация включват метод на плъзгаща се средна, метод на експоненциално изглаждане, метод на най-малките квадрати.

Същност метод на най-малките квадрати се състои в минимизиране на сумата от квадратни отклонения между наблюдаваните и изчислените стойности. Изчислените стойности се намират според избраното уравнение - регресионното уравнение. Колкото по-малко е разстоянието между действителните стойности и изчислените, толкова по-точна е прогнозата въз основа на регресионното уравнение.

Теоретичният анализ на същността на изследваното явление, промяната в който се показва от времеви ред, служи като основа за избор на крива. Понякога се вземат предвид съображенията за естеството на растежа на нивата на серията. Така че, ако растежът на продукцията се очаква в аритметична прогресия, тогава изглаждането се извършва по права линия. Ако се окаже, че растежът е експоненциален, тогава изглаждането трябва да се извърши според експоненциалната функция.

Работната формула на метода на най-малките квадрати : Y t+1 = a*X + b, където t + 1 е прогнозният период; Уt+1 – прогнозен индикатор; a и b са коефициенти; X е символ на времето.

Коефициентите a и b се изчисляват по следните формули:

|

|

където, Uf - действителните стойности на серията от динамика; n е броят на нивата във времевия ред;

Изглаждането на времевите редове по метода на най-малките квадрати служи за отразяване на закономерностите на развитие на изследваното явление. При аналитичното изразяване на тенденция времето се разглежда като независима променлива, а нивата на поредицата действат като функция на тази независима променлива.

Развитието на едно явление не зависи от това колко години са минали от началната точка, а от това какви фактори са повлияли на неговото развитие, в каква посока и с каква интензивност. От това става ясно, че развитието на едно явление във времето се появява в резултат на действието на тези фактори.

Правилното задаване на вида на кривата, вида на аналитичната зависимост от времето е една от най-трудните задачи на предсказващия анализ. .

Изборът на типа функция, която описва тенденцията, чиито параметри се определят по метода на най-малките квадрати, в повечето случаи е емпиричен, като се конструират редица функции и се сравняват една с друга по отношение на стойността на корена -средноквадратична грешка, изчислена по формулата:

|

където Uf - действителните стойности на серията от динамика; Ur – изчислени (изгладени) стойности на времевия ред; n е броят на нивата във времевия ред; p е броят на параметрите, дефинирани във формулите, описващи тенденцията (тенденцията на развитие).

Недостатъци на метода на най-малките квадрати :

- когато се опитваме да опишем икономическия феномен, който се изследва, с помощта на математическо уравнение, прогнозата ще бъде точна за кратък период от време и уравнението на регресия трябва да се преизчислява, когато се появи нова информация;

- сложността на избора на регресионното уравнение, което е разрешимо с помощта на стандартни компютърни програми.

Пример за използване на метода на най-малките квадрати за разработване на прогноза

Задача . Има данни, характеризиращи нивото на безработица в региона, %

- Изградете прогноза за нивото на безработицата в региона за месеците ноември, декември, януари, като използвате методите: пълзяща средна, експоненциално изглаждане, най-малки квадрати.

- Изчислете грешките в получените прогнози, като използвате всеки метод.

- Сравнете получените резултати, направете заключения.

Решение на най-малките квадрати

За решението ще съставим таблица, в която ще направим необходимите изчисления:

ε = 28,63/10 = 2,86% точност на прогнозатаВисоко.

Заключение : Сравняване на резултатите, получени при изчисленията метод на плъзгаща се средна , експоненциално изглаждане и метода на най-малките квадрати, можем да кажем, че средната относителна грешка при изчисленията по метода на експоненциалното изглаждане попада в рамките на 20-50%. Това означава, че точността на прогнозата в този случай е само задоволителна.

В първия и третия случай точността на прогнозата е висока, тъй като средната относителна грешка е под 10%. Но методът на плъзгащата се средна позволи да се получат по-надеждни резултати (прогноза за ноември - 1,52%, прогноза за декември - 1,53%, прогноза за януари - 1,49%), тъй като средната относителна грешка при използването на този метод е най-малката - 1 , тринадесет%.

Метод на най-малкия квадрат

Други свързани статии:

Списък на използваните източници

- Научно-методически препоръки по въпросите на диагностицирането на социалните рискове и прогнозирането на предизвикателствата, заплахите и социалните последици. Руски държавен социален университет. Москва. 2010 г.;

- Владимирова Л.П. Прогнозиране и планиране в пазарни условия: учеб. надбавка. М .: Издателство "Дашков и Ко", 2001;

- Новикова Н.В., Поздеева О.Г. Прогнозиране на народното стопанство: Учебно-методическо ръководство. Екатеринбург: Издателство Урал. състояние икономика университет, 2007;

- Слуцкин Л.Н. MBA курс по бизнес прогнозиране. Москва: Alpina Business Books, 2006.

Програма MNE

Въвеждане на данни

Данни и апроксимация y = a + b x

и- номер на опитната точка;

x i- стойността на фиксирания параметър в точката и;

y i- стойността на измервания параметър в точката и;

ω i- измерване на теглото в точка и;

y i, изч.- разликата между измерената стойност и стойността, изчислена от регресията гв точката и;

S x i (x i)- оценка на грешката x iпри измерване гв точката и.

Данни и апроксимация y = kx

| и | x i | y i | ω i | y i, изч. | Δy i | S x i (x i) |

|---|

Кликнете върху графиката

Ръководство за потребителя на онлайн програмата MNC.

В полето за данни въведете на всеки отделен ред стойностите на `x` и `y` в една експериментална точка. Стойностите трябва да бъдат разделени с интервал (интервал или раздел).

Третата стойност може да бъде теглото на точката на `w`. Ако теглото на точката не е посочено, то е равно на единица. В преобладаващото мнозинство от случаите теглата на експерименталните точки са неизвестни или не са изчислени; всички експериментални данни се считат за еквивалентни. Понякога теглата в изследвания диапазон от стойности определено не са еквивалентни и дори могат да бъдат изчислени теоретично. Например в спектрофотометрията теглата могат да бъдат изчислени с помощта на прости формули, въпреки че по принцип всички пренебрегват това, за да намалят разходите за труд.

Данните могат да бъдат поставени през клипборда от електронна таблица на офис пакет, като например Excel от Microsoft Office или Calc от Open Office. За да направите това, в електронната таблица изберете обхвата от данни за копиране, копирайте в клипборда и поставете данните в полето за данни на тази страница.

За изчисляване по метода на най-малките квадрати са необходими поне две точки за определяне на два коефициента `b` - тангенса на ъгъла на наклона на правата линия и `a` - стойността, отрязана от правата линия на `y ` ос.

За да се оцени грешката на изчислените регресионни коефициенти, е необходимо да се зададе броят на експерименталните точки на повече от две.

Метод на най-малките квадрати (LSM).

Колкото по-голям е броят на експерименталните точки, толкова по-точна е статистическата оценка на коефициентите (поради намаляването на коефициента на Студент) и толкова по-близо е оценката до оценката на общата извадка.

Получаването на стойности във всяка експериментална точка често е свързано със значителни разходи за труд, следователно често се провежда компромисен брой експерименти, което дава смилаема оценка и не води до прекомерни разходи за труд. По правило броят на експерименталните точки за линейна зависимост на най-малките квадрати с два коефициента се избира в района на 5-7 точки.

Кратка теория за най-малките квадрати за линейна зависимост

Да предположим, че имаме набор от експериментални данни под формата на двойки стойности [`y_i`, `x_i`], където `i` е броят на едно експериментално измерване от 1 до `n`; `y_i` - стойността на измерената стойност в точката `i`; `x_i` - стойността на параметъра, който задаваме в точката `i`.

Пример е действието на закона на Ом. Чрез промяна на напрежението (потенциалната разлика) между секциите на електрическата верига, ние измерваме количеството ток, преминаващ през тази секция. Физиката ни дава зависимостта, открита експериментално:

`I=U/R`,

където `I` - сила на тока; `R` - съпротивление; `U` - напрежение.

В този случай „y_i“ е измерената стойност на тока, а „x_i“ е стойността на напрежението.

Като друг пример, разгледайте поглъщането на светлина от разтвор на вещество в разтвор. Химията ни дава формулата:

`A = εl C`,

където "А" е оптичната плътност на разтвора; `ε` - пропускливост на разтвореното вещество; `l` - дължина на пътя, когато светлината преминава през кювета с разтвор; „C“ е концентрацията на разтвореното вещество.

В този случай „y_i“ е измерената оптична плътност „A“, а „x_i“ е концентрацията на веществото, което задаваме.

Ще разгледаме случая, когато относителната грешка в настройката `x_i` е много по-малка от относителната грешка при измерването на `y_i`. Ще приемем също, че всички измерени стойности на `y_i` са произволни и нормално разпределени, т.е. спазват нормалния закон за разпределение.

В случай на линейна зависимост на `y` от `x`, можем да напишем теоретичната зависимост:

`y = a + bx`.

От геометрична гледна точка коефициентът `b` обозначава тангенса на ъгъла на наклона на линията към оста `x`, а коефициентът `a` - стойността на `y` в точката на пресичане на линия с оста „y“ (за „x = 0“).

Намиране на параметрите на регресионната линия.

В експеримент измерените стойности на `y_i` не могат да лежат точно на теоретичната линия поради грешки в измерването, които винаги са присъщи на реалния живот. Следователно, едно линейно уравнение трябва да бъде представено от система от уравнения:

`y_i = a + b x_i + ε_i` (1),

където `ε_i` е неизвестната грешка при измерване на `y` в `i`-ия експеримент.

Зависимост (1) също се нарича регресия, т.е. зависимостта на двете величини една от друга със статистическа значимост.

Задачата за възстановяване на зависимостта е да се намерят коефициентите `a` и `b` от експерименталните точки [`y_i`, `x_i`].

За намиране на коефициентите обикновено се използва `a` и `b` метод на най-малкия квадрат(MNK). Това е специален случай на принципа на максималната вероятност.

Нека пренапишем (1) като `ε_i = y_i - a - b x_i`.

Тогава сумата на квадратните грешки ще бъде

`Φ = sum_(i=1)^(n) ε_i^2 = sum_(i=1)^(n) (y_i - a - b x_i)^2`. (2)

Принципът на метода на най-малките квадрати е да се минимизира сумата (2) по отношение на параметрите `a` и `b`.

Минимумът се достига, когато частичните производни на сбора (2) по отношение на коефициентите `a` и `b` са равни на нула:

`frac(частичен Φ)(частичен a) = frac(частичен сбор_(i=1)^(n) (y_i - a - b x_i)^2)(частичен a) = 0`

`frac(частичен Φ)(частичен b) = frac(частичен сбор_(i=1)^(n) (y_i - a - b x_i)^2)(частичен b) = 0`

Разширявайки производните, получаваме система от две уравнения с две неизвестни:

`sum_(i=1)^(n) (2a + 2bx_i - 2y_i) = sum_(i=1)^(n) (a + bx_i - y_i) = 0`

`sum_(i=1)^(n) (2bx_i^2 + 2ax_i - 2x_iy_i) = sum_(i=1)^(n) (bx_i^2 + ax_i - x_iy_i) = 0`

Отваряме скобите и прехвърляме сумите, независими от желаните коефициенти, към другата половина, получаваме система от линейни уравнения:

`sum_(i=1)^(n) y_i = a n + b sum_(i=1)^(n) bx_i`

`sum_(i=1)^(n) x_iy_i = a sum_(i=1)^(n) x_i + b sum_(i=1)^(n) x_i^2`

Решавайки получената система, намираме формули за коефициентите `a` и `b`:

`a = frac(sum_(i=1)^(n) y_i sum_(i=1)^(n) x_i^2 - sum_(i=1)^(n) x_i sum_(i=1)^(n ) x_iy_i) (n sum_(i=1)^(n) x_i^2 — (sum_(i=1)^(n) x_i)^2)` (3.1)

`b = frac(n sum_(i=1)^(n) x_iy_i - sum_(i=1)^(n) x_i sum_(i=1)^(n) y_i) (n sum_(i=1)^ (n) x_i^2 - (sum_(i=1)^(n) x_i)^2)` (3.2)

Тези формули имат решения, когато `n > 1` (линията може да бъде начертана с помощта на поне 2 точки) и когато детерминантата `D = n sum_(i=1)^(n) x_i^2 — (sum_(i= 1 )^(n) x_i)^2 != 0`, т.е. когато точките „x_i“ в експеримента са различни (т.е. когато линията не е вертикална).

Оценка на грешките в коефициентите на регресионната линия

За по-точна оценка на грешката при изчисляване на коефициентите `a` и `b` е желателен голям брой експериментални точки. Когато `n = 2`, е невъзможно да се оцени грешката на коефициентите, т.к апроксимиращата права ще минава еднозначно през две точки.

Определя се грешката на произволната променлива „V“. закон за натрупване на грешки

`S_V^2 = sum_(i=1)^p (frac(частично f)(частично z_i))^2 S_(z_i)^2`,

където `p` е броят на параметрите `z_i` с грешка `S_(z_i)`, които засягат грешката `S_V`;

`f` е функция на зависимост на `V` от `z_i`.

Нека напишем закона за натрупване на грешки за грешката на коефициентите `a` и `b`

`S_a^2 = sum_(i=1)^(n)(frac(частично a)(частично y_i))^2 S_(y_i)^2 + sum_(i=1)^(n)(frac(частично a )(частично x_i))^2 S_(x_i)^2 = S_y^2 sum_(i=1)^(n)(frac(частично a)(частично y_i))^2 `,

`S_b^2 = sum_(i=1)^(n)(frac(частично b)(частично y_i))^2 S_(y_i)^2 + sum_(i=1)^(n)(frac(частично b )(частично x_i))^2 S_(x_i)^2 = S_y^2 sum_(i=1)^(n)(frac(частично b)(частично y_i))^2 `,

защото `S_(x_i)^2 = 0` (преди това направихме резервация, че грешката на `x` е незначителна).

`S_y^2 = S_(y_i)^2` - грешката (дисперсия, квадратно стандартно отклонение) в измерението `y`, като се приеме, че грешката е еднаква за всички стойности на `y`.

Замествайки формули за изчисляване на "a" и "b" в получените изрази, получаваме

`S_a^2 = S_y^2 frac(sum_(i=1)^(n) (sum_(i=1)^(n) x_i^2 - x_i sum_(i=1)^(n) x_i)^2 ) (D^2) = S_y^2 frac((n sum_(i=1)^(n) x_i^2 - (sum_(i=1)^(n) x_i)^2) sum_(i=1) ^(n) x_i^2) (D^2) = S_y^2 frac(sum_(i=1)^(n) x_i^2) (D)` (4.1)

`S_b^2 = S_y^2 frac(sum_(i=1)^(n) (n x_i - sum_(i=1)^(n) x_i)^2) (D^2) = S_y^2 frac( n (n sum_(i=1)^(n) x_i^2 - (sum_(i=1)^(n) x_i)^2)) (D^2) = S_y^2 frac(n) (D) ` (4.2)

В повечето реални експерименти стойността на „Sy“ не се измерва. За да направите това, е необходимо да се извършат няколко паралелни измервания (експерименти) в една или няколко точки от плана, което увеличава времето (и евентуално цената) на експеримента. Следователно обикновено се приема, че отклонението на `y` от регресионната линия може да се счита за случайно. Оценката на дисперсията "y" в този случай се изчислява по формулата.

`S_y^2 = S_(y, почивка)^2 = frac(sum_(i=1)^n (y_i - a - b x_i)^2) (n-2)`.

Делителят `n-2` се появява, защото сме намалили броя на степените на свобода поради изчисляването на два коефициента за една и съща извадка от експериментални данни.

Тази оценка се нарича още остатъчна дисперсия спрямо линията на регресия „S_(y, rest)^2“.

Оценката на значимостта на коефициентите се извършва по критерий на Студент

`t_a = frac(|a|) (S_a)`, `t_b = frac(|b|) (S_b)`

Ако изчислените критерии `t_a`, `t_b` са по-малки от критериите на таблицата `t(P, n-2)`, тогава се счита, че съответният коефициент не се различава значително от нула с дадена вероятност `P`.

За да оцените качеството на описанието на линейна връзка, можете да сравните „S_(y, rest)^2“ и „S_(bar y)“ спрямо средната стойност, като използвате критерия на Фишер.

`S_(bar y) = frac(sum_(i=1)^n (y_i - bar y)^2) (n-1) = frac(sum_(i=1)^n (y_i - (sum_(i= 1)^n y_i) /n)^2) (n-1)` - извадкова оценка на дисперсията на „y“ спрямо средната стойност.

За да се оцени ефективността на регресионното уравнение за описание на зависимостта, се изчислява коефициентът на Фишер

`F = S_(bar y) / S_(y, почивка)^2`,

който се сравнява с табличния коефициент на Фишер `F(p, n-1, n-2)`.

Ако „F > F(P, n-1, n-2)“, разликата между описанието на зависимостта „y = f(x)“, използвайки регресионното уравнение и описанието, използващо средната стойност, се счита за статистически значима с вероятност `P`. Тези. регресията описва зависимостта по-добре от разпространението на "y" около средната стойност.

Кликнете върху графиката

за добавяне на стойности към таблицата

Метод на най-малкия квадрат. Методът на най-малките квадрати означава определяне на неизвестни параметри a, b, c, приетата функционална зависимост

Методът на най-малките квадрати означава определяне на неизвестни параметри а, б, в,…приета функционална зависимост

y = f(x,a,b,c,…),

което би осигурило минимум от средния квадрат (дисперсия) на грешката

, (24)

, (24)

където x i , y i - набор от двойки числа, получени от експеримента.

Тъй като условието за екстремум на функция от няколко променливи е условието частичните й производни да са равни на нула, то параметрите а, б, в,…се определят от системата от уравнения:

; ; ; … (25)

Трябва да се помни, че методът на най-малките квадрати се използва за избор на параметри след формата на функцията y = f(x)дефиниран.

Ако от теоретични съображения е невъзможно да се направят изводи за това каква трябва да бъде емпиричната формула, тогава човек трябва да се ръководи от визуални представяния, преди всичко графично представяне на наблюдаваните данни.

На практика най-често се ограничава до следните видове функции:

1) линейни ![]() ;

;

2) квадратно a .

Изборът на вида на регресионната функция, т.е. вида на разглеждания модел на зависимостта на Y от X (или X от Y), например линеен модел y x \u003d a + bx, е необходимо да се определят специфичните стойности на коефициентите на модел.

За различни стойности на a и b е възможно да се построят безкраен брой зависимости от вида y x =a+bx, т.е. има безкраен брой линии в координатната равнина, но имаме нужда от такава зависимост, че отговаря на наблюдаваните стойности по най-добрия начин. Така проблемът се свежда до избора на най-добрите коефициенти.

Търсим линейна функция a + bx, базирана само на определен брой налични наблюдения. За да намерим функцията, която най-добре отговаря на наблюдаваните стойности, използваме метода на най-малките квадрати.

Означете: Y i - стойността, изчислена по уравнението Y i =a+bx i . y i - измерена стойност, ε i =y i -Y i - разлика между измерените и изчислените стойности, ε i =y i -a-bx i .

Методът на най-малките квадрати изисква ε i , разликата между измереното y i и стойностите на Y i, изчислени от уравнението, да бъде минимална. Следователно намираме коефициентите a и b, така че сумата от квадратните отклонения на наблюдаваните стойности от стойностите на правата регресионна линия да е най-малката:

Изследвайки тази функция на аргументи a и с помощта на производни до екстремум, можем да докажем, че функцията придобива минимална стойност, ако коефициентите a и b са решения на системата:

(2)

(2)

Ако разделим двете страни на нормалното уравнение на n, получаваме:

Предвид това  (3)

(3)

Вземи  , от тук, замествайки стойността на a в първото уравнение, получаваме:

, от тук, замествайки стойността на a в първото уравнение, получаваме:

В този случай b се нарича коефициент на регресия; a се нарича свободен член на регресионното уравнение и се изчислява по формулата:

Получената права линия е оценка за теоретичната регресионна линия. Ние имаме:

Така, ![]() е линейно регресионно уравнение.

е линейно регресионно уравнение.

Регресията може да бъде директна (b>0) и обратна (b Пример 1. Резултатите от измерването на стойностите X и Y са дадени в таблицата:

| x i | -2 | 0 | 1 | 2 | 4 |

| y i | 0.5 | 1 | 1.5 | 2 | 3 |

Приемайки, че има линейна връзка между X и Y y=a+bx, определете коефициентите a и b, като използвате метода на най-малките квадрати.

Решение. Тук n=5

x i =-2+0+1+2+4=5;

x i 2 =4+0+1+4+16=25

x i y i =-2 0,5+0 1+1 1,5+2 2+4 3=16,5

y i =0,5+1+1,5+2+3=8

и нормалната система (2) има формата ![]()

Решавайки тази система, получаваме: b=0,425, a=1,175. Следователно y=1,175+0,425x.

Пример 2. Има извадка от 10 наблюдения на икономически индикатори (X) и (Y).

| x i | 180 | 172 | 173 | 169 | 175 | 170 | 179 | 170 | 167 | 174 |

| y i | 186 | 180 | 176 | 171 | 182 | 166 | 182 | 172 | 169 | 177 |

Необходимо е да се намери примерно регресионно уравнение Y-on-X. Построете примерна регресионна линия Y-on-X.

Решение. 1. Нека сортираме данните по стойности x i и y i . Получаваме нова маса:

| x i | 167 | 169 | 170 | 170 | 172 | 173 | 174 | 175 | 179 | 180 |

| y i | 169 | 171 | 166 | 172 | 180 | 176 | 177 | 182 | 182 | 186 |

За да опростим изчисленията, ще съставим изчислителна таблица, в която ще въведем необходимите числови стойности.

| x i | y i | x i 2 | x i y i |

| 167 | 169 | 27889 | 28223 |

| 169 | 171 | 28561 | 28899 |

| 170 | 166 | 28900 | 28220 |

| 170 | 172 | 28900 | 29240 |

| 172 | 180 | 29584 | 30960 |

| 173 | 176 | 29929 | 30448 |

| 174 | 177 | 30276 | 30798 |

| 175 | 182 | 30625 | 31850 |

| 179 | 182 | 32041 | 32578 |

| 180 | 186 | 32400 | 33480 |

| ∑x i =1729 | ∑y i =1761 | ∑x i 2 299105 | ∑x i y i =304696 |

| х=172,9 | y=176,1 | x i 2 =29910.5 | xy=30469.6 |

Съгласно формула (4) изчисляваме коефициента на регресия

и по формула (5)

По този начин, извадковото регресионно уравнение изглежда като y=-59.34+1.3804x.

Нека начертаем точките (x i ; y i) в координатната равнина и маркираме регресионната линия.

Фиг.4

Фигура 4 показва как са разположени наблюдаваните стойности спрямо линията на регресия. За да оценим числено отклоненията на y i от Y i , където y i са наблюдавани стойности, а Y i са стойности, определени чрез регресия, ще направим таблица:

| x i | y i | Y и | Y i -y i |

| 167 | 169 | 168.055 | -0.945 |

| 169 | 171 | 170.778 | -0.222 |

| 170 | 166 | 172.140 | 6.140 |

| 170 | 172 | 172.140 | 0.140 |

| 172 | 180 | 174.863 | -5.137 |

| 173 | 176 | 176.225 | 0.225 |

| 174 | 177 | 177.587 | 0.587 |

| 175 | 182 | 178.949 | -3.051 |

| 179 | 182 | 184.395 | 2.395 |

| 180 | 186 | 185.757 | -0.243 |

Стойностите на Y i се изчисляват според регресионното уравнение.

Забележимото отклонение на някои наблюдавани стойности от регресионната линия се обяснява с малкия брой наблюдения. При изследване на степента на линейна зависимост на Y от X се взема предвид броят на наблюденията. Силата на зависимостта се определя от стойността на коефициента на корелация.

Метод на най-малкия квадратсе използва за оценка на параметрите на регресионното уравнение.Един от методите за изследване на стохастичните връзки между характеристиките е регресионният анализ.

Регресионният анализ е извличане на регресионно уравнение, което се използва за намиране на средната стойност на произволна променлива (функция-резултат), ако е известна стойността на друга (или други) променливи (характеристики-фактори). Тя включва следните стъпки:

- избор на формата на свързване (вид на аналитичното регресионно уравнение);

- оценка на параметрите на уравнението;

- оценка на качеството на аналитичното регресионно уравнение.

В случай на линейна двойна връзка, регресионното уравнение ще приеме вида: y i =a+b·x i +u i . Параметрите на това уравнение a и b са оценени от данните от статистическото наблюдение x и y . Резултатът от такава оценка е уравнението: , където , - оценки на параметрите a и b , - стойността на ефективния признак (променлива), получена чрез регресионното уравнение (изчислена стойност).

Най-често използваният за оценка на параметрите е метод на най-малките квадрати (LSM).

Методът на най-малките квадрати дава най-добрите (последователни, ефективни и безпристрастни) оценки на параметрите на регресионното уравнение. Но само ако са изпълнени определени предположения относно произволния член (u) и независимата променлива (x) (вижте допусканията на OLS).

Проблемът за оценка на параметрите на уравнение на линейна двойка по метода на най-малките квадратисе състои в следното: да се получат такива оценки на параметрите , , при които сумата от квадратите на отклоненията на действителните стойности на ефективния признак - y i от изчислените стойности - е минимална.

формално OLS критерийможе да се напише така:  .

.

Класификация на методите на най-малките квадрати

- Метод на най-малкия квадрат.

- Метод на максималното вероятност (за нормален класически линеен регресионен модел се постулира нормалността на остатъците от регресия).

- Обобщеният метод на най-малките квадрати на GLLS се използва в случай на автокорелация на грешката и в случай на хетероскедастичност.

- Метод на претеглени най-малки квадрати (специален случай на GLSM с хетероскедастични остатъци).

Илюстрирайте същността класическият метод на най-малките квадрати графично. За да направим това, ще изградим точков график според данните от наблюдение (x i , y i , i=1;n) в правоъгълна координатна система (такава точкова диаграма се нарича корелационно поле). Нека се опитаме да намерим права линия, която е най-близо до точките на корелационното поле. Съгласно метода на най-малките квадрати линията се избира така, че сумата от квадратите на вертикалните разстояния между точките на корелационното поле и тази права да бъде минимална.

Математическа нотация на този проблем:  .

.

Стойностите на y i и x i =1...n са ни известни, това са данни от наблюдения. Във функцията S те са константи. Променливите в тази функция са необходимите оценки на параметрите - , . За да се намери минимума на функция от 2 променливи, е необходимо да се изчислят частните производни на тази функция по отношение на всеки от параметрите и да се приравнят на нула, т.е.  .

.

В резултат на това получаваме система от 2 нормални линейни уравнения:

Решавайки тази система, намираме необходимите оценки на параметрите:

Коректността на изчислението на параметрите на регресионното уравнение може да се провери чрез сравняване на сумите (възможно е известно несъответствие поради закръгляване на изчисленията).

За да изчислите оценките на параметрите, можете да изградите таблица 1.

Знакът на коефициента на регресия b показва посоката на връзката (ако b > 0, връзката е пряка, ако b<0, то связь обратная). Величина b показывает на сколько единиц изменится в среднем признак-результат -y при изменении признака-фактора - х на 1 единицу своего измерения.

Формално стойността на параметъра a е средната стойност на y за x, равно на нула. Ако знак-факторът няма и не може да има нулева стойност, тогава горната интерпретация на параметъра a няма смисъл.

Оценка на плътността на връзката между характеристиките

се извършва с помощта на коефициента на линейна двойна корелация - r x,y . Може да се изчисли по формулата:  . В допълнение, коефициентът на корелация на линейна двойка може да бъде определен по отношение на коефициента на регресия b:

. В допълнение, коефициентът на корелация на линейна двойка може да бъде определен по отношение на коефициента на регресия b:  .

.

Диапазонът на допустимите стойности на линейния коефициент на корелация на двойката е от –1 до +1. Знакът на коефициента на корелация показва посоката на връзката. Ако r x, y >0, тогава връзката е директна; ако r x, y<0, то связь обратная.

Ако този коефициент е близо до единица по модул, тогава връзката между характеристиките може да се интерпретира като доста близка линейна. Ако неговият модул е равен на едно ê r x , y ê =1, тогава връзката между характеристиките е функционално линейна. Ако характеристиките x и y са линейно независими, тогава r x,y е близо до 0.

Таблица 1 може да се използва и за изчисляване на r x,y.

За да се оцени качеството на полученото регресионно уравнение, се изчислява теоретичният коефициент на детерминация - R 2 yx:  ,

,

където d 2 е дисперсията y, обяснена с регресионното уравнение;

e 2 - остатъчна (необяснена от регресионното уравнение) дисперсия y ;

s 2 y - обща (обща) дисперсия y .

Коефициентът на детерминация характеризира съотношението на вариация (дисперсия) на резултантния признак y, обяснено с регресия (и следователно с фактор x), в общата вариация (дисперсия) y. Коефициентът на детерминация R 2 yx приема стойности от 0 до 1. Съответно стойността 1-R 2 yx характеризира дела на дисперсията y, причинена от влиянието на други фактори, които не са взети предвид в модела и грешките в спецификацията.

Със сдвоена линейна регресия R 2 yx =r 2 yx .

Метод на най-малкия квадрат

Метод на най-малкия квадрат ( MNK, OLS, обикновени най-малки квадрати) - един от основните методи за регресионен анализ за оценка на неизвестни параметри на регресионни модели от извадкови данни. Методът се основава на минимизиране на сумата от квадратите на остатъци от регресия.

Трябва да се отбележи, че самият метод на най-малките квадрати може да се нарече метод за решаване на задача във всяка област, ако решението се състои от или удовлетворява определен критерий за минимизиране на сумата от квадрати на някои функции на неизвестните променливи. Следователно методът на най-малките квадрати може да се използва и за приблизително представяне (приближение) на дадена функция от други (по-прости) функции, когато се намира набор от величини, които отговарят на уравнения или ограничения, чийто брой надвишава броя на тези величини , и т.н.

Същността на MNC

Нека някакъв (параметричен) модел на вероятностна (регресионна) зависимост между (обяснената) променлива ги много фактори (обяснителни променливи) х

където е векторът на неизвестни параметри на модела

- Случайна грешка на модела.Нека има и примерни наблюдения на стойностите на посочените променливи. Нека е номерът на наблюдение (). След това са стойностите на променливите в -тото наблюдение. След това, за дадени стойности на параметрите b, е възможно да се изчислят теоретичните (моделни) стойности на обяснената променлива y:

Стойността на остатъците зависи от стойностите на параметрите b.

Същността на LSM (обикновена, класическа) е да се намерят такива параметри b, за които сумата от квадратите на остатъците (инж. Остатъчна сума от квадрати) ще бъде минимално:

В общия случай този проблем може да бъде решен чрез числени методи за оптимизация (минимизиране). В този случай се говори за нелинейни най-малки квадрати(NLS или NLLS - английски. Нелинейни най-малки квадрати). В много случаи може да се получи аналитично решение. За да се реши задачата за минимизиране, е необходимо да се намерят стационарните точки на функцията, като се диференцира по отношение на неизвестните параметри b, приравнените на производните към нула и се реши получената система от уравнения:

Ако случайните грешки на модела са нормално разпределени, имат една и съща дисперсия и не са корелирани една с друга, оценките на параметрите на най-малките квадрати са същите като оценките на метода на максималното правдоподобие (MLM).

LSM в случай на линеен модел

Нека регресионната зависимост е линейна:

Нека бъде г- вектор колона на наблюденията на обяснената променлива и - матрица на наблюденията на факторите (редове на матрицата - вектори на стойностите на факторите в дадено наблюдение, по колони - вектор на стойностите на даден фактор във всички наблюдения) . Матричното представяне на линейния модел има формата:

Тогава векторът на оценките на обяснената променлива и векторът на остатъците от регресията ще бъдат равни на

съответно сумата от квадратите на остатъците от регресията ще бъде равна на

Диференцирайки тази функция по отношение на вектора на параметрите и приравнявайки производните към нула, получаваме система от уравнения (в матрична форма):

.Решението на тази система от уравнения дава общата формула за оценките на най-малките квадрати за линейния модел:

За аналитични цели последното представяне на тази формула се оказва полезно. Ако данните в регресионния модел центриран, то в това представяне първата матрица има значението на извадковата ковариационна матрица на фактори, а втората е векторът на ковариациите на фактори със зависима променлива. Ако освен това данните са също нормализиранв SKO (тоест в крайна сметка стандартизиран), тогава първата матрица има значението на извадковата корелационна матрица на факторите, вторият вектор - вектора на извадковите корелации на факторите със зависимата променлива.

Важно свойство на LLS оценките за модели с константа- линията на конструираната регресия минава през центъра на тежестта на извадковите данни, тоест е изпълнено равенството:

По-специално, в краен случай, когато единственият регресор е константа, откриваме, че оценката на OLS за един параметър (самата константа) е равна на средната стойност на променливата, която се обяснява. Тоест средноаритметичната, известна с добрите си свойства от законите за големите числа, също е оценка на най-малките квадрати – тя удовлетворява критерия за минимална сума на квадратните отклонения от нея.

Пример: проста (по двойки) регресия

В случай на сдвоена линейна регресия, формулите за изчисление са опростени (можете да направите без матрична алгебра):

Свойства на оценките на OLS

На първо място, отбелязваме, че за линейните модели оценките на най-малките квадрати са линейни, както следва от горната формула. За безпристрастни оценки на OLS е необходимо и достатъчно да се изпълни най-важното условие на регресионния анализ: математическото очакване на случайна грешка, обусловено от факторите, трябва да бъде равно на нула. Това условие е изпълнено, по-специално, ако

- математическото очакване на случайни грешки е нула, и

- факторите и случайните грешки са независими случайни величини.

Второто условие - състоянието на екзогенни фактори - е основно. Ако това свойство не е удовлетворено, тогава можем да предположим, че почти всички оценки ще бъдат изключително незадоволителни: те дори няма да бъдат последователни (тоест дори много голямо количество данни не позволява получаването на качествени оценки в този случай). В класическия случай се прави по-силно предположение за детерминираността на факторите, за разлика от случайната грешка, което автоматично означава, че екзогенното условие е изпълнено. В общия случай за последователност на оценките е достатъчно да се изпълни условието за екзогенност заедно с конвергенцията на матрицата към някаква несингулярна матрица с увеличаване на размера на извадката до безкрайност.

За да могат, в допълнение към последователността и безпристрастността, (обикновените) оценки на най-малките квадрати също да бъдат ефективни (най-добрите в класа на линейните безпристрастни оценки), трябва да бъдат удовлетворени допълнителни свойства на случайна грешка:

Тези допускания могат да бъдат формулирани за ковариационната матрица на вектора на случайната грешка

Линеен модел, който удовлетворява тези условия, се нарича класически. OLS оценките за класическа линейна регресия са безпристрастни, последователни и най-ефективни оценки в класа на всички линейни безпристрастни оценки (в английската литература понякога се използва съкращението син (Най-добър линеен небазиран оценител) е най-добрата линейна безпристрастна оценка; в родната литература по-често се цитира теоремата на Гаус-Марков). Както е лесно да се покаже, ковариационната матрица на вектора на оценките на коефициента ще бъде равна на:

Обобщени най-малки квадрати

Методът на най-малките квадрати позволява широко обобщение. Вместо да се минимизира сумата от квадратите на остатъците, може да се минимизира някаква положително определена квадратична форма на остатъчния вектор, където е някаква симетрична матрица с положително определено тегло. Обикновените най-малки квадрати са специален случай на този подход, когато матрицата на теглото е пропорционална на матрицата за идентичност. Както е известно от теорията на симетричните матрици (или оператори), има декомпозиция за такива матрици. Следователно, посоченият функционал може да бъде представен по следния начин, тоест този функционал може да бъде представен като сума от квадратите на някои трансформирани "остатъци". По този начин можем да различим клас от методи с най-малки квадрати - LS-методи (Най-малки квадрати).

Доказано е (теоремата на Айткен), че за обобщен линеен регресионен модел (при който не се налагат ограничения върху ковариационната матрица на случайните грешки) най-ефективни (в класа на линейните безпристрастни оценки) са оценките на т.нар. обобщен OLS (OMNK, GLS - обобщени най-малки квадрати)- LS-метод с тегловна матрица, равна на обратната ковариационна матрица на случайните грешки: .

Може да се покаже, че формулата за GLS-оценките на параметрите на линейния модел има формата

Ковариационната матрица на тези оценки, съответно, ще бъде равна на

Всъщност същността на OLS се крие в определена (линейна) трансформация (P) на оригиналните данни и прилагането на обичайните най-малки квадрати към трансформираните данни. Целта на тази трансформация е, че за трансформираните данни случайните грешки вече отговарят на класическите допускания.

Претеглени най-малки квадрати

В случай на диагонална матрица на тежестта (и оттам на ковариационната матрица на случайните грешки) имаме така наречените претеглени най-малки квадрати (WLS - Weighted Least Squares). В този случай претеглената сума от квадратите на остатъците на модела е минимизирана, тоест всяко наблюдение получава „тежест“, което е обратно пропорционално на дисперсията на случайната грешка в това наблюдение: . Всъщност данните се трансформират чрез претегляне на наблюденията (разделяне на количество, пропорционално на приетото стандартно отклонение на случайните грешки) и нормалните най-малки квадрати се прилагат към претеглените данни.

Някои специални случаи на приложение на LSM в практиката

Линейна апроксимация

Помислете за случая, когато в резултат на изследване на зависимостта на определена скаларна величина от определена скаларна величина (Това може да бъде например зависимостта на напрежението от силата на тока: , където е постоянна стойност, съпротивлението на проводника ), тези количества бяха измерени, в резултат на което стойностите и бяха получени съответните им стойности. Данните от измерването трябва да бъдат записани в таблица.

Таблица. Резултати от измерването.

| Измерване № | ||

|---|---|---|

| 1 | ||

| 2 | ||

| 3 | ||

| 4 | ||

| 5 | ||

| 6 |

Въпросът звучи така: каква стойност на коефициента може да бъде избрана, за да опише най-добре зависимостта? Според най-малките квадрати тази стойност трябва да бъде такава, че сумата от квадратните отклонения на стойностите от стойностите

беше минимално

Сборът от квадрати отклонения има един екстремум - минимум, което ни позволява да използваме тази формула. Нека намерим стойността на коефициента от тази формула. За да направите това, трансформираме лявата му страна, както следва:

Последната формула ни позволява да намерим стойността на коефициента, който беше необходим в задачата.

История

До началото на XIX век. учените не са имали определени правила за решаване на система от уравнения, в която броят на неизвестните е по-малък от броя на уравненията; До този момент се използваха определени методи, в зависимост от вида на уравненията и от изобретателността на калкулаторите, и следователно различните калкулатори, изхождайки от едни и същи данни от наблюдения, стигаха до различни заключения. На Гаус (1795) се приписва първото приложение на метода, а Лежандре (1805) независимо го открива и публикува под съвременното му име (фр. Methode des moindres quarres ) . Лаплас свързва метода с теорията на вероятностите, а американският математик Адрейн (1808 г.) разглежда неговите вероятностни приложения. Методът е широко разпространен и подобрен чрез по-нататъшни изследвания на Encke, Bessel, Hansen и др.

Алтернативно използване на ТНК

Идеята за метода на най-малките квадрати може да се използва и в други случаи, които не са пряко свързани с регресионния анализ. Факт е, че сумата от квадрати е една от най-често срещаните мерки за близост за вектори (евклидовата метрика в крайномерните пространства).

Едно приложение е "решаване" на системи от линейни уравнения, в които броят на уравненията е по-голям от броя на променливите

където матрицата не е квадратна, а правоъгълна.

Такава система от уравнения в общия случай няма решение (ако рангът действително е по-голям от броя на променливите). Следователно тази система може да бъде „решена“ само в смисъл на избор на такъв вектор, за да се сведе до минимум „разстоянието“ между векторите и . За да направите това, можете да приложите критерия за минимизиране на сумата от квадратите на разликите на лявата и дясната част на уравненията на системата, т.е. Лесно е да се покаже, че решението на тази задача за минимизиране води до решението на следната система от уравнения